Scaling Law与AI推理模型的发展

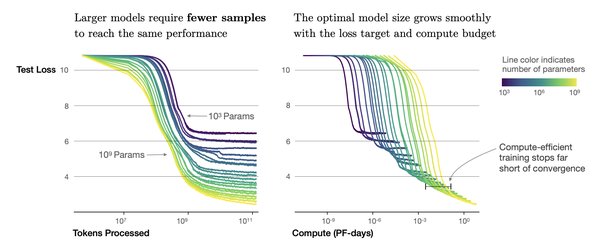

近年来,人工智能的发展遵循三条AI扩展定律(Scaling Law),分别是预训练扩展、后训练扩展和测试时扩展。这三条定律共同反映了AI大模型的演变过程,尤其是在推理模型中的应用。

-

预训练扩展阶段(Pre-Training Scaling)

通过提升训练数据集规模、模型参数数量以及增加计算资源,开发者能够实现模型的智能化水平和准确率的提升。随着多模态数据(如文本、图像、音频、视频)的广泛应用,预训练扩展定律的适用性将持续增强。 -

后训练扩展阶段(Post-Training Scaling)

这一阶段通过微调、剪枝、量化、蒸馏、强化学习和合成数据增强等技术,进一步提高预训练模型的性能,使其更适应特定场景的需求。 -

测试时扩展阶段(Test-Time Scaling)

传统的AI模型会根据用户提示快速生成一次性答案,而测试时扩展技术则允许模型在推理过程中进行额外计算,探索不同解决方案,从而得出最佳答案。

DeepSeek的开源模型R1:AI领域的新活力

今年1月,中国人工智能初创公司DeepSeek发布的开源推理模型R1在海外引起巨大反响。这一创新不仅颠覆了AI产业的既有格局,还引发了一场关于技术路径与商业模式的深刻变革。DeepSeek的低成本、高效能开源模式,为AI领域注入了新的活力。

| 模型名称 | 特点 | 影响 |

|---|---|---|

| DeepSeek-R1 | 低成本、高效能 | 推动更多模型开源,降低AI技术应用门槛 |

DeepSeek的开源模式打破了传统封闭的技术壁垒,让研究者、开发者和企业能够在已有基础上进行模型迭代和优化。这一转变极大降低了AI技术的应用门槛,促进了跨行业的应用,如政务、医疗、金融和教育等领域。

英伟达的机遇与挑战

尽管DeepSeek的创新引发市场波动,导致英伟达单日市值一度蒸发近6000亿美元,但英伟达首席执行官黄仁勋公开回应称,未来的人工智能模型仍将依赖英伟达的计算能力。英伟达凭借其在GPU和AI加速芯片领域的技术积累和生态构建优势,仍将在AI算力市场中占据主导地位。

-

技术积累与生态构建

英伟达的Ampere架构和Hopper架构GPU被广泛应用于数据中心和AI模型训练场景,成为大规模数据中心的核心引擎。其CUDA平台和软件工具(如cuDNN、TensorRT等)进一步巩固了其在AI芯片领域的技术优势。 -

数据中心业务的主导地位

英伟达的数据中心业务在2025财年达到1,152亿美元的营收,占总营收的88%。随着AI推理模型对算力需求的不断增加,英伟达的数据中心业务将继续受益。 -

开源模型的潜在影响

尽管开源模型降低了AI技术的应用门槛,但英伟达通过其软硬件一体化解决方案,依然能够为开发者和企业提供优化的工具和框架支持。开源模型的普及反而可能推动市场对英伟达高性能芯片的需求。

结论

Scaling Law在AI推理模型中的应用,为人工智能的发展提供了新的动力。DeepSeek的开源模型R1为AI领域注入了新的活力,尽管对英伟达产生了一定的市场波动,但英伟达凭借其技术积累和生态构建优势,仍将在AI算力市场中占据主导地位。未来,随着AI推理模型的不断发展,英伟达有望继续受益于这一趋势,推动人工智能产业的进一步繁荣。