ResNet与深度学习的演进

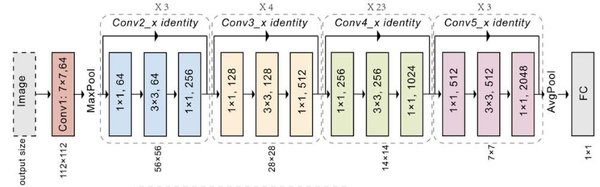

ResNet(残差网络)自2015年提出以来,一直是深度学习领域的里程碑式模型。其核心思想是通过引入“残差连接”解决了深层网络中的梯度消失问题,使得训练更深的神经网络成为可能。ResNet的成功不仅推动了计算机视觉的发展,也为其他领域的深度学习模型提供了重要启示。

深度学习的“10层假说”

在2024年NeurIPS会议上,Ilya Sutskever回顾了深度学习的“10层假说”。这一假说认为,神经网络的性能在达到10层左右时会趋于饱和,而ResNet通过残差连接打破了这一限制。Sutskever指出,ResNet的设计理念为后续模型的开发提供了重要参考,尤其是在处理复杂任务时,深层网络的表现显著优于浅层网络。

预训练模式的局限性

Sutskever在演讲中预测,预训练模式已经走到尽头。尽管预训练模型在自然语言处理和计算机视觉等领域取得了巨大成功,但其局限性也逐渐显现。例如,预训练模型需要大量的计算资源和数据,且在某些任务上的泛化能力有限。Sutskever提出,未来的研究方向应聚焦于更高效的训练方法和更智能的模型架构。

未来超级智能系统的关键特征

Sutskever还提出了未来超级智能系统的三个关键特征:

- 自适应性:系统能够根据环境和任务的变化自动调整其行为和策略。

- 推理能力:系统具备高级的逻辑推理和问题解决能力,能够处理复杂的抽象任务。

- 安全性:系统在设计上确保其行为符合人类的价值观和伦理规范,避免潜在的危害。

自回归模型的突破性认知

自回归模型(如GPT系列)在自然语言处理领域取得了显著进展。Sutskever指出,这些模型的成功在于其能够捕捉语言的长期依赖关系,并生成连贯的文本。然而,他也强调,自回归模型在处理复杂推理任务时仍存在局限性,未来的研究需要探索更强大的推理机制。

AI推理能力的深刻见解

Sutskever对AI推理能力的深刻见解为未来的研究指明了方向。他认为,AI系统不仅需要具备强大的模式识别能力,还需要发展出类似人类的逻辑推理和抽象思维能力。这一目标的实现将依赖于更先进的模型架构和训练方法。

总结

ResNet的成功为深度学习的发展奠定了坚实基础,而Sutskever在NeurIPS会议上的演讲则为未来的研究提供了重要启示。从“10层假说”到超级智能系统的关键特征,深度学习正在不断突破自身的边界。未来的研究将聚焦于更高效的训练方法、更智能的模型架构以及更强大的推理能力,为AI的发展开辟新的可能性。

| 关键点 | 描述 |

|---|---|

| ResNet | 通过残差连接解决深层网络梯度消失问题 |

| 10层假说 | 神经网络性能在10层左右趋于饱和 |

| 预训练模式 | 需要大量计算资源和数据,泛化能力有限 |

| 超级智能系统 | 自适应性、推理能力、安全性 |

| 自回归模型 | 捕捉语言长期依赖关系,生成连贯文本 |

| AI推理能力 | 发展逻辑推理和抽象思维能力 |

通过以上分析,我们可以看到,ResNet不仅是深度学习的重要里程碑,也为未来的AI研究提供了宝贵的经验和启示。