DeepSeek的核心架构:MoE+MLA+MTP

DeepSeek以其高效和创新的AI模型架构而闻名,其核心架构MoE+MLA+MTP在业界引起了广泛关注。

MoE架构:高效推理的基石

MoE(Mixture of Experts)架构是DeepSeek高效推理的关键。该架构将AI模型分割成多个子模型,每个子模型专注于特定领域。在推理过程中,AI会根据问题类型激活相关子模型,从而大幅提高效率。这种架构不仅降低了推理成本,还减少了硬件需求。

MLA机制:多头潜在注意力机制

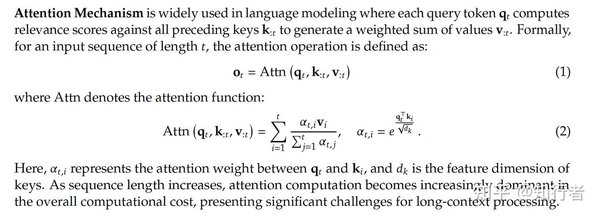

MLA(Multi-Head Latent Attention)机制通过压缩注意力头的键和值,显著提高了推理效率。传统的多头注意力机制需要遍历所有数据,而MLA则通过智能检索机制,快速锁定相关数据区间,大幅减少了无效检索时间。

MTP机制:多令牌预测

MTP(Multi-Token Prediction)机制通过同时进行多个推理步骤,显著提高了模型的训练和推理效率。这种机制使得生成的文本更加流畅自然,更接近人类的写作方式。

强化学习:AI的自我进化

DeepSeek在AI训练中引入了强化学习机制,使得AI能够通过自我推理和反思不断进化。这种训练方式不仅减少了人工标注的成本,还使得AI能够在推理过程中自我优化,逐步接近正确答案。

强化学习的实践

在DeepSeek的强化学习过程中,AI会自主比对推理结果与标准答案,废弃低分结果,并在接近正确答案的基础上进行新一轮推理。这种训练方式使得AI的思维链越来越长,甚至出现了自我反思的能力。

NSA注意力机制:超快长上下文训练

DeepSeek提出的NSA(Neural Sparse Attention)注意力机制,能够显著提高长文本的训练和推理速度。该机制将长文本切割成512字的数据块,通过动态筛选机制,让AI自主决定需要检索哪些数据块,从而大幅提高了推理准确率。

NSA的应用前景

NSA注意力机制不仅提高了长文本的处理效率,还为AI在长篇小说创作、解读等领域的应用提供了新的可能性。未来,AI将能够直接阅读数十万字的巨作,并记住其中绝大多数的细节。

开源精神:推动全球AI技术进步

DeepSeek在开源技术领域的贡献,不仅推动了全球AI技术的进步,还为AI行业带来了新的发展机遇。

FlashMLA:GPU算力的优化

FlashMLA是一款面向Hopper GPU的高效MLA解码内核,通过优化可变长度序列的服务场景,显著提高了算力效率。经过FlashMLA优化的H800计算卡,其算力甚至超越了H100的默认算力。

DeepEP:MoE模型的通信革命

DeepEP是一款针对MoE模型训练和推理所设计的EP(专家并行)通信库,通过优化通信机制,显著降低了延迟和数据传输速率问题。

DeepGEMM:FP8精度的训练优化

DeepGEMM是一个专为FP8通用矩阵乘法设计的库,通过智能纠错方式,解决了FP8精度训练中的溢出问题,显著降低了训练成本。

结语

DeepSeek通过其创新的AI模型架构和开源精神,不仅推动了全球AI技术的进步,还为AI行业带来了新的发展机遇。未来,随着DeepSeek技术的进一步推广和应用,我们有望迎来AI技术的新一轮爆发。