随着人工智能技术的快速发展,视觉生成模型在多模态任务中的应用日益广泛。然而,这些模型在安全性和可靠性方面仍面临诸多挑战。2025年,大模型安全问题成为业界关注的焦点,尤其是视觉生成模型的安全对齐问题,成为推动AI技术高质量发展的关键。

安全对齐的紧迫性

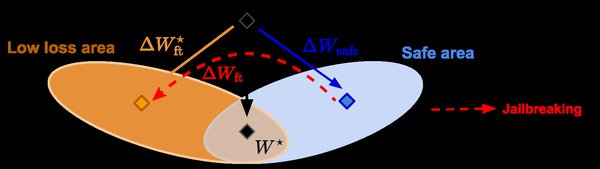

视觉生成模型的核心挑战在于如何将视觉信息与文本信息无缝融合,同时确保模型的安全性。传统的多模态模型在处理视觉与文本嵌入时,往往存在“语言隔阂”,导致信息表达不精确,甚至可能引发安全隐患。例如,模型在面对越狱攻击时,容易产生幻觉问题,即过于自信地提供错误信息。

RealSafe-R1:安全对齐的突破

2025年2月,清华大学和瑞莱智慧联合团队推出的RealSafe-R1模型,为大模型的安全对齐提供了重要解决方案。该模型在DeepSeekR1的基础上进行了深度优化,通过创新的安全对齐机制和内省推理技术,显著提升了模型的安全性。实验数据显示,RealSafe-R1在多个基准测试中表现优异,尤其是在抵抗越狱攻击方面,超越了包括Claude3.5和GPT-4o在内的闭源大模型。

RealSafe-R1的核心创新在于其自我纠错与安全意识的思维链分析方法。这一技术使模型能够通过自我检查潜在风险,实现自我进化,从而有效减轻了安全性与性能之间的“跷跷板”现象。这一突破不仅为开源大模型的安全性加固树立了新标杆,也为政务、金融、医疗等领域的应用提供了可信赖的技术基础。

Ovis架构:视觉与文本的融合

在多模态大模型领域,Ovis架构的推出为视觉与文本嵌入的对齐提供了新思路。Ovis通过引入结构化视觉嵌入表,成功解决了传统模型中视觉与文本嵌入方式不匹配的问题。这一创新不仅提升了视觉信息的表达精度,还为多模态学习开辟了新的可能性。

Ovis架构的核心理念是将视觉信息与文本信息统一在一个嵌入框架内,从而实现无缝融合。这一设计使得模型在处理复杂多模态任务时,能够更准确地理解和生成内容,同时降低安全隐患。

未来展望

视觉生成模型的安全对齐不仅是技术问题,更是推动AI产业高质量发展的关键。随着RealSafe-R1和Ovis等创新技术的推出,我们有理由相信,未来AI系统在安全性和可靠性方面将取得更大突破。然而,这需要持续的技术投入和跨领域的合作,尤其是在多模态大模型的安全对齐机制上,仍需进一步探索和完善。

视觉生成模型的安全对齐是AI技术发展的必经之路。通过不断的技术创新和实践,我们有望构建一个更加安全、可靠的人工智能生态系统,为各行各业的应用提供坚实的技术支撑。