推荐系统算法审计的背景与意义

随着生成式大模型的快速发展,推荐系统在互联网平台中的应用日益广泛。然而,大模型在推荐系统中可能存在的安全风险,如算法偏见、隐私泄露和内容操控等,已成为亟需解决的问题。算法审计作为一种有效的风险管理工具,能够帮助识别和应对这些潜在风险,确保推荐系统的公平性、透明性和安全性。

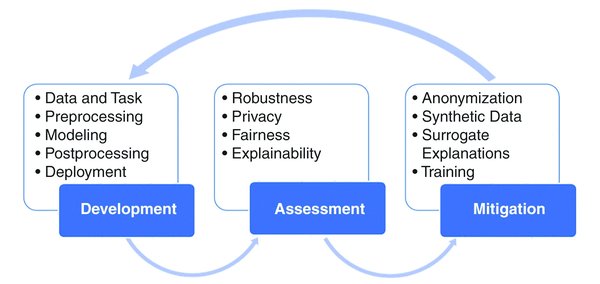

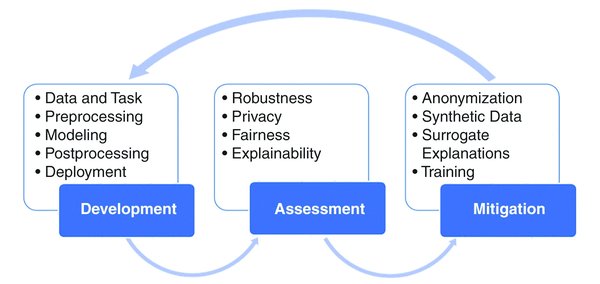

推荐系统算法审计的核心框架

风险评估

风险评估是算法审计的第一步,旨在识别推荐系统中可能存在的风险类型及其影响程度。具体步骤包括:

-

风险识别:通过专家访谈、案例分析和问卷调查等方法,构建推荐系统的风险类型库,如算法偏见风险、数据隐私风险等。

-

风险分析:运用定量或定性方法评估风险级别,例如根据用户规模、数据敏感性和社会影响范围等维度进行评分。

-

风险评价:确定哪些风险可接受、哪些需要规避或消减,例如对于算法偏见问题,可以通过事后规则调整进行处理。

风险管理

风险管理是算法审计的核心环节,旨在通过全链条风险控制机制确保推荐系统的安全性。具体措施包括:

-

上市前管理:

-

政府层面:建立备案系统和安全测评体系,确保推荐系统符合质量标准。

-

企业层面:开展伦理审查,构建内部风险控制体系,明确董事会为风险管理的直接责任人。

-

上市后管理:

-

政府层面:实施定期审计,跟踪安全状态,更新国家标准。

-

企业层面:优化技术治理措施,动态调整内部治理组织。

风险沟通

风险沟通是算法审计的重要补充,旨在通过信息共享和公众参与提升推荐系统的透明度。具体措施包括:

-

搭建信息平台:及时发布风险监测数据和评估报告,接受社会监督。

-

多元主体参与:通过专家研讨会、公开辩论等方式,促进政府、企业和公众之间的风险对话。

推荐系统算法审计的实施路径

分级分类治理

分级分类治理是算法审计的重要方法,强调根据风险程度采取差异化管理措施。例如:

-

高风险场景:涉及用户隐私或社会公共利益的推荐系统,应制定严格的规范和透明度要求。

-

低风险场景:可采用事后责任救济制度,发挥企业自我规制的作用。

技术治理与伦理对齐

技术治理是推荐系统算法审计的重要手段,例如通过价值对齐确保推荐内容符合人类价值观。同时,伦理对齐也是不可或缺的环节,例如通过伦理审查和宣传,提升企业的社会责任意识。

面向未来的算法审计展望

随着人工智能技术的不断发展,推荐系统算法审计将面临更多挑战和机遇。未来,应进一步加强风险评估的科学性和独立性,优化风险管理的全链条机制,并提升风险沟通的透明度和公众参与度。同时,应积极探索分级分类治理的创新路径,推动推荐系统在安全可控的前提下实现可持续发展。

通过算法审计,我们不仅能够有效应对推荐系统中的安全风险,还能为共建人工智能安全未来提供坚实保障。