随着大模型在自然语言处理、视觉问答等领域的广泛应用,其事实性增强和安全性问题日益受到关注。2025年第2期聚焦大模型安全问题,深入探讨了大模型可能存在的安全风险,并提出了相应的解决方案。本文将从幻觉检测、安全对齐、视觉问答基准等角度,全面解析大模型事实性增强的最新进展。

幻觉检测:代码生成与大模型评估的挑战

幻觉问题是大模型面临的主要挑战之一,尤其是在代码生成领域。CodeMirage首次提出了代码幻觉的定义和分类,并构建了包含1137个幻觉代码片段的基准数据集。通过实验发现,开源和闭源模型在代码生成中均存在不同程度的幻觉问题。研究者提出了多种缓解策略,包括提示工程和模型微调,以提高代码生成的事实性和可靠性。

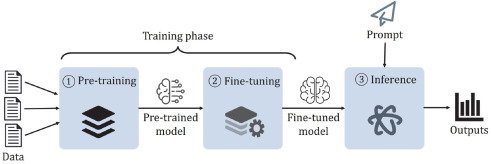

安全对齐:大模型自主进化的新路径

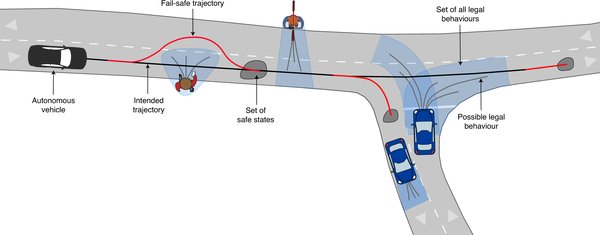

清华大学与瑞莱智慧联合团队推出的RealSafe-R1系列模型,通过将安全对齐与内省推理相结合,实现了大模型的自主进化。实验表明,RealSafe-R1在多个基准测试中显著增强了对越狱攻击的抵抗力,并缓解了安全与性能之间的“跷跷板”现象。这一创新方法为开源大模型的安全性加固提供了有力支持,为政务、金融、医疗等场景应用奠定了更可靠的基础。

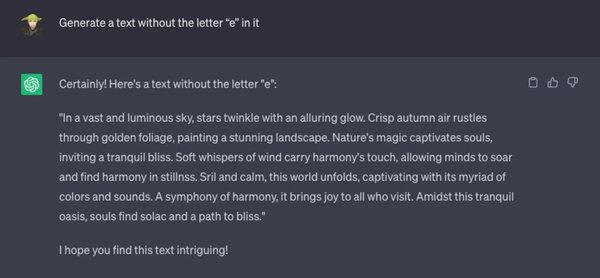

视觉问答基准:事实性评估的新标杆

淘天集团未来生活实验室推出的ChineseSimpleVQA,是首个面向事实知识的中文视觉问答基准。该基准包含1100幅图片和2200个问答对,涵盖8个主要话题和56个子话题。通过严格的自动验证、难度筛选和人工验证流程,ChineseSimpleVQA展现了多模态大模型在知识边界和执行机制上的深度评估能力。实验结果显示,o1-preview在识别问题和知识扩展问题上表现最佳,但幻觉问题仍是主要挑战。

未来展望:共建人工智能安全未来

大模型事实性增强的研究仍在不断深入。从幻觉检测到安全对齐,再到视觉问答基准的构建,每一步都为大模型的可靠性和安全性提供了新的解决方案。未来,随着技术的持续创新和跨领域合作的加强,人工智能产业将迈向更高质量的发展,为各行业提供更安全、更可信的智能服务。

通过以上探索,我们不仅看到了大模型事实性增强的潜力,也明确了未来研究的方向。只有持续投入和攻坚,才能为人工智能的安全未来奠定坚实基础。