随着人工智能技术的快速发展,对抗性学习技术逐渐成为研究热点。这种技术不仅在光学成像领域取得了突破性进展,也在人工智能安全领域引发了新的挑战。本文将从这两个角度探讨对抗性学习技术的应用与影响。

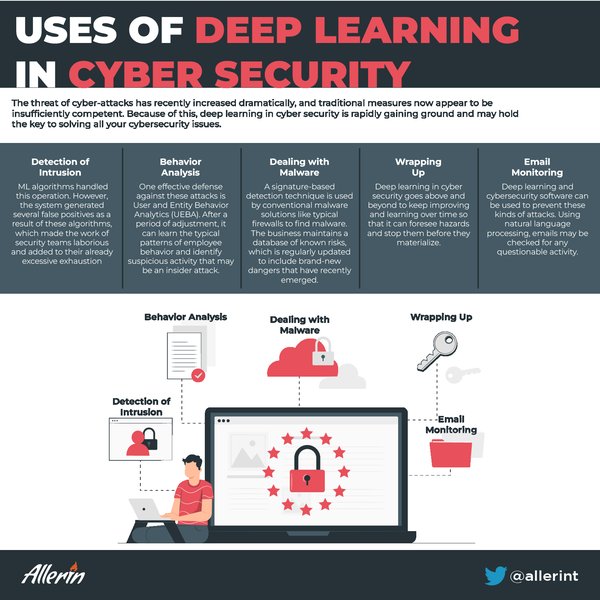

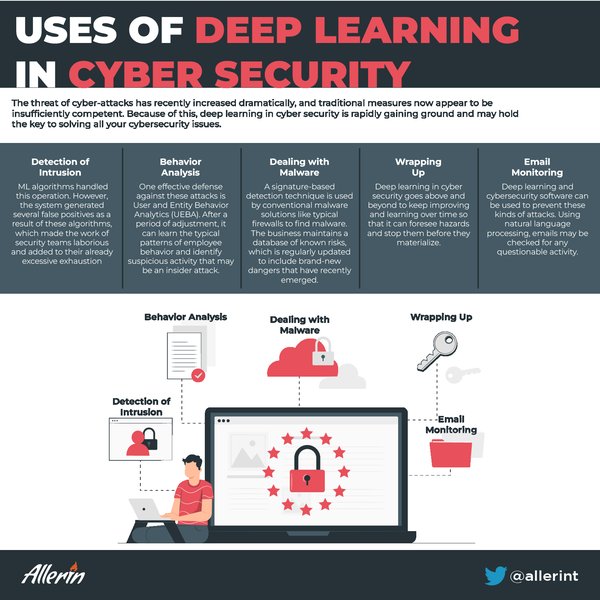

人工智能安全的潜在威胁

近年来,深度学习技术在人工智能领域的应用日益广泛,但其安全性问题也日益凸显。360安全研究院发布的《AI安全风险白皮书》指出,深度学习框架中的软件实现漏洞、对抗性样本生成以及训练数据污染等问题,可能导致人工智能系统出现误判、漏判甚至被劫持的风险。

深度学习框架的漏洞

深度学习框架简化了应用开发流程,但也因其复杂性暗藏风险。一旦框架或其依赖组件存在漏洞,整个系统都可能面临威胁。例如,内存访问越界、空指针引用等漏洞可能导致系统崩溃或被攻击者控制。

对抗性样本的威胁

对抗性样本是通过精心设计的输入数据,旨在误导深度学习模型。以手写数字识别为例,恶意构造的输入可能导致系统分类错误甚至崩溃。这种技术不仅暴露了算法的安全盲点,也为攻击者提供了新的工具。

光学成像领域的突破

在人工智能安全领域面临挑战的同时,对抗性学习技术也在光学成像领域取得了重大突破。韩国浦项科技大学的研究团队利用深度学习技术开发出一种新型超薄金属透镜,为智能手机、VR和AR设备的光学元件设计开辟了新途径。

超薄超透镜的创新

该技术的核心是直径10毫米的超薄超透镜,结合深度学习驱动的图像恢复框架,实现了高分辨率、全彩色、无像差的图像输出。研究人员通过对抗性学习技术不断优化系统,校正颜色失真和模糊问题,显著提升了成像质量。

未来应用前景

Junsuk Rho教授表示,这一技术为创造更小、更高效的成像系统提供了新思路。未来,超薄超透镜有望广泛应用于消费电子、医疗成像和工业检测等领域,推动光学技术的革新。

结语

对抗性学习技术既是人工智能安全的潜在威胁,也是光学成像领域的重要推动力。在享受技术红利的同时,我们也要警惕其可能带来的风险,通过技术创新和安全防护,实现技术的可持续发展。