薛复昭加入Google DeepMind:MoE研究的新篇章

近日,华人博士薛复昭宣布加入Google DeepMind,担任高级研究科学家,专注于Gemini预训练和多模态研究。薛复昭博士毕业于新加坡国立大学,师从尤洋教授,曾在Google Brain和NVIDIA GEAR实习,与Yi Tay、Mostafa Dehghani、Jim Fan等知名科学家合作。他的研究方向包括大语言模型预训练、Transformer扩展和条件计算,尤其在混合专家(MoE)领域取得了显著成果。

MoE:大语言模型的高效解决方案

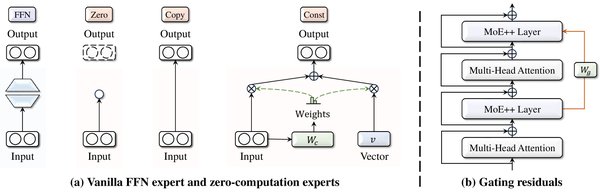

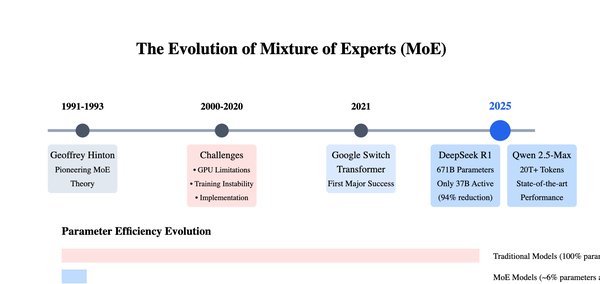

混合专家(MoE)是一种通过条件计算提升模型效率的技术,近年来在大语言模型研究中备受关注。薛复昭在其研究中发现,MoE不仅能够显著降低模型训练成本,还能通过超参数调整实现高效开发。他的研究表明,MoE架构在视觉Transformer模型中的应用,如WideNet框架,能够在更少参数下提升性能。例如,在ImageNet-1K数据集上,WideNet在0.72倍可训练参数时,比Vision Transformer高出1.46%。

科研新人的七点成长建议

薛复昭博士结合自身经历,为科研新人总结了七点宝贵建议:

-

工程能力是研究的基础:实现AI想法需要强大的工程能力,这是将研究转化为实践的关键。

-

与优秀人才合作:通过与顶尖科学家合作,可以提升研究品味,识别前沿方向。

-

专注演讲而非发表记录:简洁而深刻的演讲比论文数量更能展示研究能力。

-

筛选高质量论文:专注于影响力大的工作和知名作者,避免信息过载。

-

按时间顺序阅读论文:识别研究趋势演变,发现未来方向。

-

换位思考提升写作和演讲:从读者角度出发,提升表达清晰性和可理解性。

-

博士学位并非唯一途径:直接加入研究实验室也能为最先进的大语言模型做出贡献。

MoE在大语言模型中的未来

薛复昭的研究不仅为MoE技术提供了实证支持,也为大语言模型的高效开发指明了方向。他的工作表明,MoE在解决大模型训练中的Token危机和性能下降问题方面具有巨大潜力。未来,MoE技术有望在更多领域得到应用,推动AI研究的进一步发展。

薛复昭博士的加入为Google DeepMind注入了新的活力,他的研究成果和科研建议也为AI领域的年轻学者提供了宝贵的指导。在AI技术飞速发展的时代,如何高效利用资源与团队协作,将是科研新人迈向成功的关键。