Transformer模型的优化挑战

Transformer模型自问世以来,凭借其强大的序列建模能力,在自然语言处理、计算机视觉等领域取得了显著成果。然而,随着模型规模的不断扩大,如何有效减少模型大小、提高训练稳定性和泛化能力,成为了研究者们亟待解决的问题。

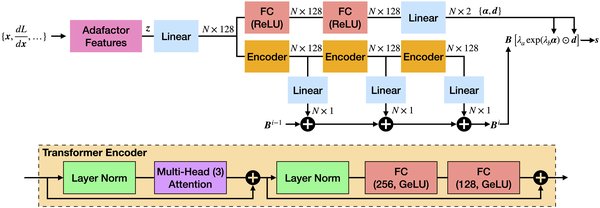

PLATON算法的创新之处

在ICML2022上,研究者们提出了一种名为PLATON的算法,该算法通过重要性估计的置信上限(UCB)来捕捉Transformer模型中权重重要性得分的不确定性。这一创新性的方法,不仅能够有效减少模型大小,还能显著提高训练稳定性和泛化能力。

重要性估计的置信上限(UCB)

PLATON算法的核心在于其重要性估计的置信上限(UCB)。通过这一机制,算法能够更加准确地评估模型中各个权重的重要性,从而在模型剪枝过程中做出更为明智的决策。这一方法不仅减少了模型的冗余,还提高了模型的整体性能。

实验结果的显著改进

实验结果表明,PLATON算法在多个基于Transformer的模型上均表现出显著的改进。无论是在模型大小、训练稳定性还是泛化能力方面,PLATON都展现出了其独特的优势。这一成果为Transformer模型的优化提供了新的思路和方法。

未来展望

随着深度学习技术的不断发展,Transformer模型的优化将面临更多的挑战和机遇。PLATON算法的成功,不仅为当前的模型优化提供了有效的解决方案,也为未来的研究指明了方向。我们期待,在不久的将来,能够看到更多类似PLATON的创新算法,推动Transformer模型在各个领域的应用和发展。

通过本文的介绍,我们不难看出,PLATON算法在Transformer模型优化方面所取得的突破性进展。这一成果不仅为研究者们提供了新的工具和方法,也为广大开发者带来了更为高效和稳定的模型应用体验。让我们共同期待,PLATON算法在未来的更多精彩表现。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...