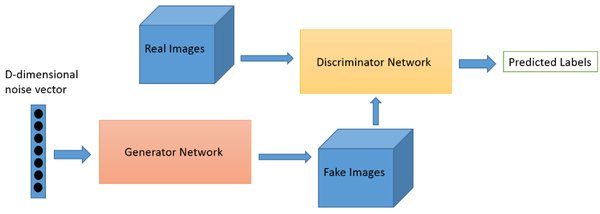

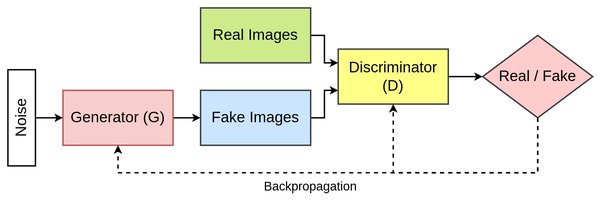

GAN的提出与影响

生成对抗网络(GAN)自提出以来,迅速成为深度学习领域的重要研究方向。GAN通过生成器和判别器的对抗训练,能够生成逼真的图像,广泛应用于图像生成、风格迁移等领域。然而,随着研究的深入,GAN也面临着一系列挑战,如理论基础的缺乏、数据集的局限性等。

GAN的最新进展

1. 理论基础的构建

当前大多数GAN方法依赖于经验观察或启发式方法,缺乏明确的理论基础。这不仅限制了其在不同生成模型中的泛化能力,也影响了其在实际应用中的稳定性。因此,构建GAN的理论基础成为未来研究的重要方向。

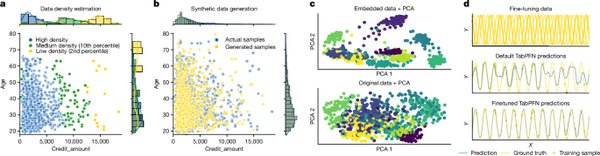

2. 高质量与多样化数据集

传统数据集在图像质量和数据集偏差方面存在局限性,这对现有方法的训练和准确性评估提出了挑战。开发更多样化和高质量的数据集,对于提升GAN的性能至关重要。

3. 替代检测范式

现有方法通常使用单一检测模型进行跨架构的通用检测,这在实践中极具挑战性。探索替代检测范式,如开发针对特定架构的专用模型,并融合多模型的能力,有望为GAN的应用带来新的突破。

GAN的实践指南

使用PyTorch搭建GAN模型

PyTorch作为深度学习的主流框架,为搭建GAN模型提供了强大的支持。以下是一个简单的VAE(变分自编码器)模型示例,展示了如何使用PyTorch构建生成模型:

“`python

import torch

from torch import nn

class VAE(nn.Module):

def __init__(self, input_dim, hidden_dim, latent_dim):

super(VAE, self).__init__()

self.encoder = nn.Sequential(

nn.Linear(input_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, latent_dim * 2) # mean and log variance

)

self.decoder = nn.Sequential(

nn.Linear(latent_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, input_dim),

nn.Sigmoid()

)

def encode(self, x):

h = self.encoder(x)

mu, log_var = h.chunk(2, dim=-1)

return mu, log_var

def reparameterize(self, mu, log_var):

std = torch.exp(0.5 * log_var)

eps = torch.randn_like(std)

return mu + eps * std

def decode(self, z):

return self.decoder(z)

“`

未来研究方向

1. 神经网络规模与模型复杂度的关系

研究GAN神经网络规模、模型复杂度和训练集大小之间的关系,有助于解决该方法的可扩展性问题。

2. 跨领域应用

将GAN应用于其他领域和跨领域应用,如智能城市中的物流系统决策支持和智能旅游行程预订建模,将为其带来更广泛的应用前景。

3. 开源工具与框架

开发开源工具和框架,如OrGAN库,不仅为开发者提供了便利,也为研究者提供了宝贵的资源,推动了GAN技术的普及和发展。

结论

GAN作为深度学习领域的重要研究方向,其理论基础的构建、高质量数据集的开发以及替代检测范式的探索,将为未来的研究和应用带来新的机遇。通过使用PyTorch等工具,开发者可以更高效地搭建和优化GAN模型,推动其在图像生成等领域的应用。