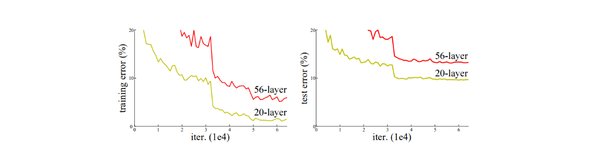

残差网络的诞生背景

在深度学习的早期,研究人员发现,随着网络层数的增加,模型的性能反而会下降。这一现象被称为“退化问题”,其根源在于信息在深层网络中的磨损和梯度消失。残差网络(ResNet)的提出,正是为了解决这一难题。

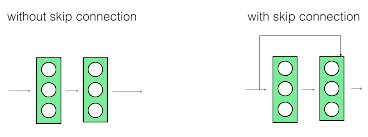

残差网络的工作原理

残差网络的核心思想是引入“跳跃连接”(Skip Connection),即在每一层的输出端,直接将输入信号原封不动地叠加到处理结果上。用公式表示为输出 = 输入X + 处理结果F(X)。这种设计确保了原始信息能够无损传递到网络的深层,有效避免了信息磨损和梯度消失。

残差连接的三重功效

-

保留原始信息:无论网络对数据做了多么复杂的变换,原始信号始终通过“直达专线”畅通无阻。

-

强制分工协作:网络层只需要学习“输入与输出的差异部分”(即残差F(X)),而不是从头重建整个输出。

-

动态纠错机制:下一层网络能同时看到“原始版本”和“加工版本”,通过对比自动识别处理过程中的偏差。

残差网络的应用场景

残差网络不仅在图像分类任务中表现出色,还被广泛应用于视频编码、自然语言处理等领域。例如,在HEVC(高效视频编码)标准下,卷积神经网络(CNN)通过预测重构块的残差,显著提高了视频编码的视觉质量和效率。

视频编码中的残差网络

-

简化版CNN(S-CNN)和复杂版CNN(C-CNN):用于改善帧内编码性能,通过训练这两种模型来预测重构块的残差。

-

计算复杂度与编码性能的权衡:提出了一种早期终止机制和基于GPU的异构架构加速方法,进一步提升了编码效率。

残差网络的哲学启示

残差连接最初只是为解决技术难题而生,却意外揭示了深度学习的重要规律:在复杂系统中保留原始通路,往往比盲目增加复杂度更有效。这一思想在自然进化中早有印证:

-

DNA复制时保留原始遗传信息链

-

大脑神经元既有新突触连接,也保留原始神经回路

-

文明发展过程中,新技术往往与旧体系共存而非替代

结语

残差网络通过其独特的“跳跃连接”设计,不仅解决了深层网络训练中的难题,还为深度学习的发展提供了新的思路。在追求技术进步的同时,保留原始信息的理念,或许正是我们面对复杂系统时应有的智慧。