万相2.1模型:视频生成技术的革新

阿里巴巴近日宣布全面开源其视频生成模型万相2.1,这一举措标志着视频生成技术迈入了一个新的阶段。万相2.1基于Apache2.0协议,支持文生视频和图生视频任务,全球开发者可在Github、HuggingFace和魔搭社区下载体验。这一开源模型不仅降低了开发者的使用门槛,还为他们提供了强大的技术支持,以开展与自身业务相关的各类视频生成应用。

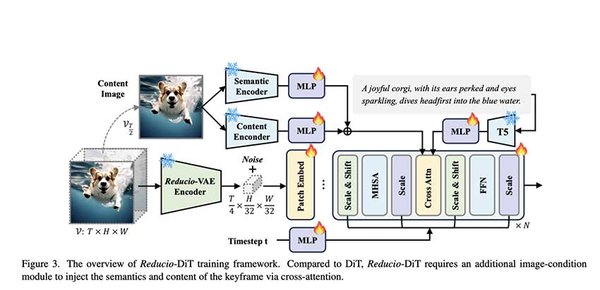

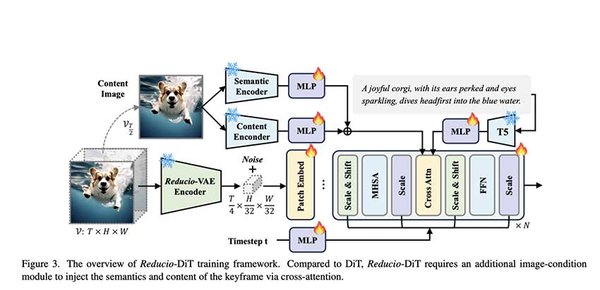

技术亮点:高效VAE与DiT架构

万相2.1模型通过自研的高效VAE(变分自编码器)和DiT(深度时空变换器)架构,显著增强了时空上下文建模能力。这一技术突破使得模型能够支持无限长1080P视频的高效编解码,极大地提升了视频生成的效率和质量。此外,万相2.1还首次实现了中文文字视频生成功能,为中文内容的视频制作提供了更多可能性。

跨平台兼容性与应用场景

万相2.1的开源不仅限于技术层面的创新,其跨平台兼容性也为开发者带来了极大的便利。无论是Windows、Unix还是Mac系统,开发者都可以轻松地在不同平台上运行和优化万相2.1模型。这一特性使得万相2.1在跨平台开发中表现出色,能够广泛应用于教育、娱乐、广告等多个领域。

开发者社区与未来展望

随着万相2.1的开源,全球开发者社区将迎来一个新的发展机遇。开发者可以通过Github、HuggingFace和魔搭社区获取模型的底层代码,进行二次开发和优化。这不仅有助于推动视频生成技术的进一步发展,还将为各行各业的视频应用提供更多创新解决方案。

万相2.1模型的开源是阿里巴巴在视频生成技术领域的一次重要突破。通过自研的高效VAE和DiT架构,万相2.1不仅提升了视频生成的效率和质量,还首次实现了中文文字视频生成功能。这一开源模型将为全球开发者提供强大的技术支持,推动视频生成技术的广泛应用和持续创新。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...