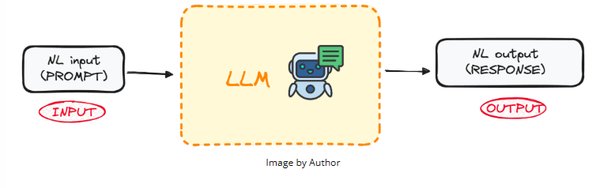

1. 微调LLMs的重要性

大型语言模型(LLMs)在自然语言处理(NLP)领域取得了显著进展,但预训练模型往往需要针对特定任务进行微调,以提升其性能和适应性。Hugging Face作为领先的NLP平台,提供了丰富的工具和资源,帮助开发者高效地进行模型微调。

2. 2024年微调LLMs的课程

2024年,Hugging Face推出了一系列课程,涵盖了从基础到高级的微调技术。这些课程包括:

-

基础课程:介绍微调的基本概念和工具,适合初学者。

-

进阶课程:深入探讨微调策略和优化技巧,适合有一定经验的开发者。

-

实战课程:通过实际项目,帮助开发者将微调技术应用到真实场景中。

3. 2025年微调LLMs的课程

2025年,Hugging Face进一步扩展了课程内容,新增了以下课程:

-

跨平台微调:讲解如何在不同的硬件和操作系统上进行微调,提升模型的兼容性。

-

多任务学习:探讨如何通过微调实现多任务学习,提高模型的泛化能力。

-

模型压缩与加速:介绍如何通过微调实现模型的压缩和加速,提升部署效率。

4. 实用技巧与工具

在进行微调时,开发者可以借助以下工具和技巧:

-

Hugging Face Transformers库:提供了丰富的预训练模型和微调接口,简化了微调过程。

-

数据集管理:通过Hugging Face Datasets库,可以方便地管理和加载数据集,提高数据处理效率。

-

自动化微调:利用Hugging Face Trainer类,可以实现自动化微调,减少手动操作。

5. 未来展望

随着技术的不断发展,微调LLMs的方法和工具也将持续更新。开发者应持续关注Hugging Face的最新动态,及时掌握最新的微调技术和课程,以保持在NLP领域的竞争力。

通过本文的介绍,开发者可以全面了解如何通过Hugging Face在2024年和2025年微调LLMs,并利用相关课程和工具提升模型性能和应用效果。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...