GPU加速向量数据库的技术革新

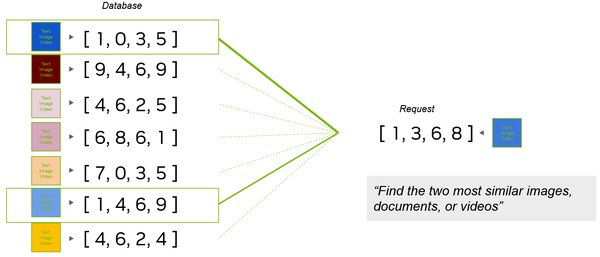

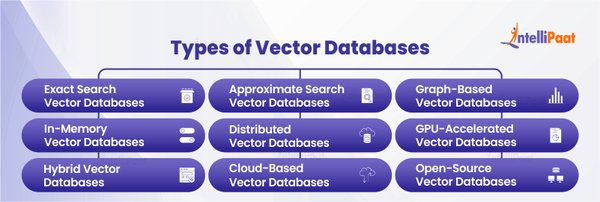

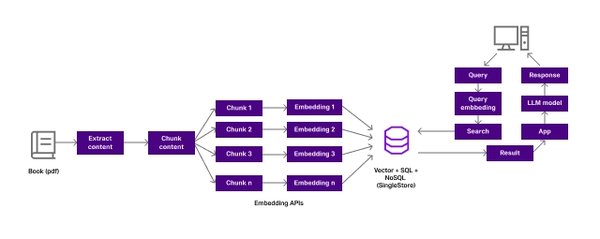

近年来,随着AI大模型的快速发展,向量数据库作为支持海量数据高效检索的关键技术,逐渐成为业界关注的焦点。英伟达与Zilliz合作发布的全球首个GPU加速向量数据库,标志着这一领域的技术革新迈出了重要一步。GPU加速向量数据库通过利用GPU的高并行计算能力,显著提升了向量数据的查询、检索和召回效率,为AI大模型提供了强大的算力支持。

GPU加速的核心优势

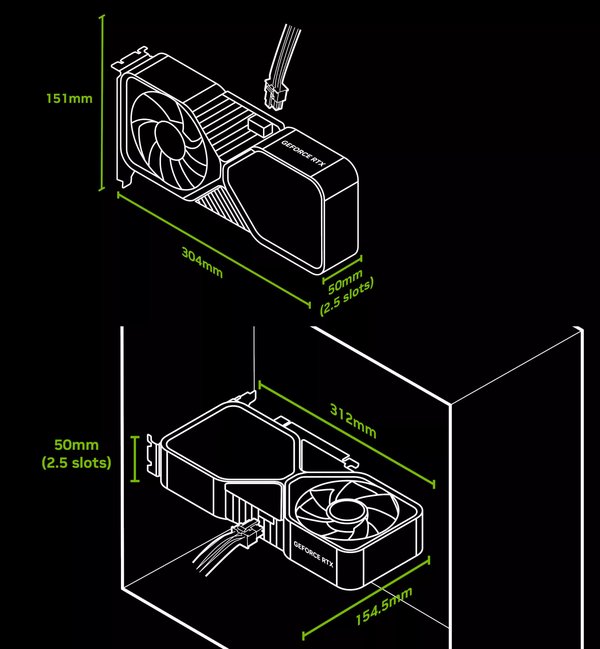

GPU加速向量数据库的核心优势在于其高效的计算能力和内存带宽。以英伟达的Hopper架构GPU为例,其Tensor Core单元能够加速矩阵运算,显著提升向量相似性搜索的性能。此外,GPU的高带宽内存(如HBM)可以快速处理大规模向量数据,满足AI大模型对实时性的要求。

低秩压缩与高效计算

在技术层面,GPU加速向量数据库采用了低秩联合压缩技术,通过将高维向量映射到低维潜在空间,大幅减少了内存占用和计算开销。例如,DeepSeek的FlashMLA技术通过低秩压缩将KV缓存需求降低了93.3%,同时保持了高效的推理性能。这种技术不仅降低了硬件成本,还提高了系统的整体效率。

应用场景与行业影响

GPU加速向量数据库在多个领域展现了广泛的应用潜力,尤其是在AI大模型的训练和推理中,其价值尤为突出。

实时查询与检索

在实时查询场景中,GPU加速向量数据库能够快速处理海量数据,满足高并发需求。例如,在推荐系统中,向量数据库可以实时检索用户兴趣相关的商品或内容,提升用户体验。英特尔发布的AIGC向量数据库解决方案,正是针对这一需求设计,实现了高实时性的数据检索与召回。

多模态数据处理

随着多模态AI模型的普及,GPU加速向量数据库在图像、文本和音频等数据的融合处理中发挥了重要作用。例如,在智能客服系统中,向量数据库可以同时处理用户输入的文本和语音信息,提供更精准的回复。铠侠的AiSAQ™技术通过优化SSD存储,进一步降低了多模态数据处理的计算成本。

未来展望与挑战

尽管GPU加速向量数据库在技术上取得了显著进展,但其未来发展仍面临一些挑战。

生态整合与标准化

目前,GPU加速向量数据库的生态尚未完全成熟,不同厂商的技术方案存在兼容性问题。未来,行业需要推动统一的标准和协议,促进技术的普及与应用。例如,RISC-V国际基金会正在推动AI指令集的标准化,为GPU加速向量数据库的生态整合提供了新的思路。

成本与能效优化

随着模型规模的不断扩大,GPU加速向量数据库的硬件成本和能耗问题日益凸显。未来,厂商需要探索更高效的存储和计算方案,例如采用QLC闪存和CXL技术,以降低系统成本并提升能效。铠侠的第八代BiCS FLASH™技术在这一领域展现了巨大的潜力。

总结

GPU加速向量数据库作为AI大模型的重要基础设施,正在推动人工智能技术的快速发展。通过低秩压缩、硬件感知优化和高效计算,这一技术显著提升了向量数据的处理效率,为实时查询、多模态数据处理等应用场景提供了强大的支持。未来,随着生态整合和成本优化的不断推进,GPU加速向量数据库将在更多领域发挥重要作用,为AI技术的普及和应用注入新的动力。