强化学习赋能:QwQ-32B的技术突破

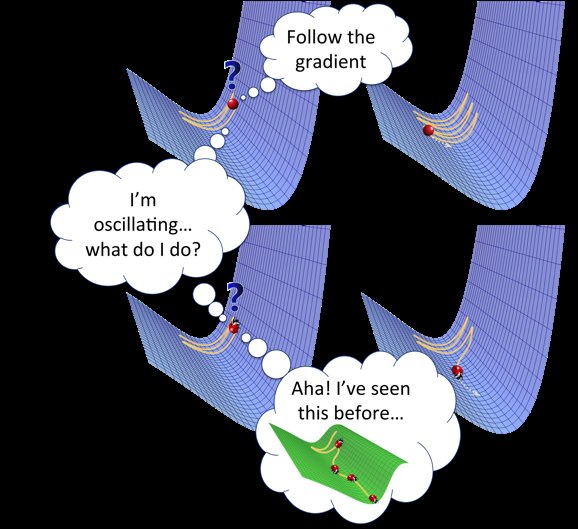

阿里开源的最新推理模型QwQ-32B,以其320亿参数的规模,通过大规模强化学习(RL)训练,展现了与6710亿参数的DeepSeek-R1相媲美的性能。这一突破不仅验证了强化学习在提升模型推理能力方面的巨大潜力,也为中型模型挑战巨型模型提供了新的可能性。

性能表现:数学与编程的卓越表现

QwQ-32B在多个基准测试中表现优异,尤其是在数学推理和编程任务上。例如,在AIME24评测集和LiveCodeBench中,其表现与DeepSeek-R1相当,甚至在某些测试中超越了后者。这一成果得益于其独特的RL训练方法,通过校验生成答案的正确性和代码执行服务器评估,确保了模型的高效性和准确性。

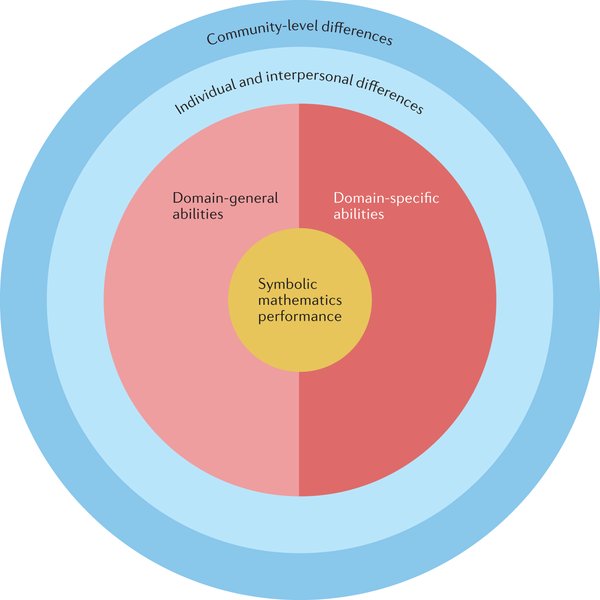

强化学习的持续扩展

QwQ-32B的RL训练分为两个阶段:首先是针对数学和编程任务的专门训练,随后是通用能力的提升。这种分阶段的训练策略不仅提升了模型在特定领域的性能,还保持了其在其他通用任务上的表现。这种持续扩展的RL训练方法,为未来模型的进一步优化提供了新的思路。

未来展望:通往通用人工智能的可行之路

QwQ-32B的成功发布,标志着阿里在强化学习领域的重大进展。团队表示,未来将继续探索更强大的基础模型与规模化计算资源的结合,以实现更高层次的智能。此外,智能体与RL的集成,也将成为未来研究的重要方向,目标是通过推理时间扩展来释放更高的智能。

用户反馈与社区反响

QwQ-32B一经发布,便引发了广泛关注和热烈讨论。许多用户对其在本地设备上的运行表现表示满意,尤其是在高配置的Mac设备上。尽管其参数规模较小,但通过与检索增强生成(RAG)等技术的结合,QwQ-32B在实际应用中展现了强大的潜力。

结语

QwQ-32B的发布,不仅展示了强化学习在大语言模型中的巨大潜力,也为中型模型挑战巨型模型提供了新的可能。随着技术的不断进步,我们期待QwQ-32B在未来的表现,以及其在实现通用人工智能道路上的更多突破。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...