引言

自2017年Transformer架构的引入以来,大型语言模型(LLMs)已成为人工智能领域的核心驱动力。从GPT-3到ChatGPT,再到2025年的DeepSeek-R1,LLMs不仅在技术上取得了巨大突破,还深刻改变了我们与AI互动的方式。本文将回顾这一革命性历程,探讨LLMs的关键里程碑及其对社会和行业的影响。

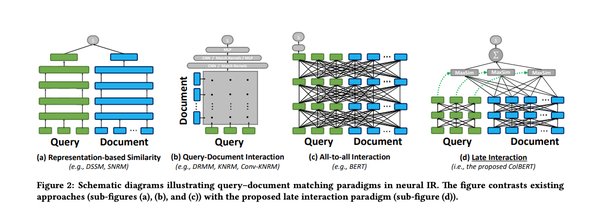

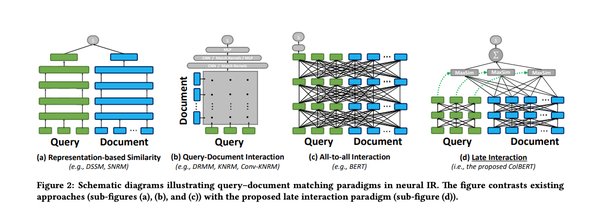

Transformer架构:LLMs的基石

2017年,Vaswani等人提出的Transformer架构彻底改变了自然语言处理(NLP)领域。Transformer通过自注意力机制解决了传统循环神经网络(RNNs)和长短期记忆网络(LSTMs)在长程依赖性和计算效率上的局限性。其关键创新包括:

– 自注意力机制:动态权衡每个标记的重要性,提升全局上下文理解。

– 多头注意力:并行处理输入的多个方面,生成更丰富的上下文表示。

– 位置编码:保留词序信息,支持并行化计算。

Transformer的引入为LLMs的大规模训练和高效处理复杂任务奠定了基础。

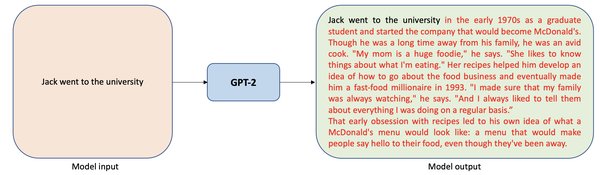

GPT系列:生成能力的巅峰

OpenAI的GPT系列模型展示了自回归语言模型的强大生成能力:

– GPT-1(2018):首次将Transformer解码器用于大规模预训练,开启了生成式AI的新时代。

– GPT-2(2019):凭借15亿参数,展示了零样本学习的潜力。

– GPT-3(2020):1750亿参数的规模使其在少样本和零样本任务中表现出色,树立了AI能力的标杆。

GPT系列不仅在文本生成、翻译和问答任务中表现出色,还为内容创作和对话式AI开辟了新的可能性。

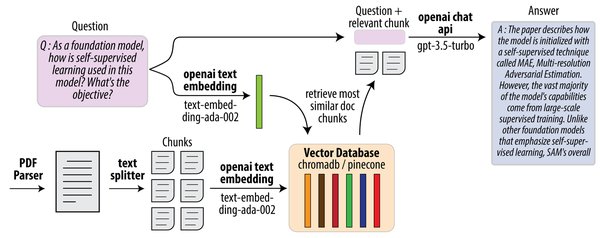

后训练对齐:确保AI与人类价值观一致

随着GPT-3等模型生成内容的真实性引发担忧,研究人员开始关注如何使LLMs与人类价值观保持一致。2021年至2022年间,监督微调(SFT)和基于人类反馈的强化学习(RLHF)成为关键技术:

– SFT:通过高质量输入-输出对训练模型,使其生成准确且符合上下文的响应。

– RLHF:利用人类反馈优化模型输出,显著提升对齐性和性能。

ChatGPT的推出标志着对话式AI的重大突破,展示了RLHF在生成诚实和无害响应方面的潜力。

多模态模型:连接文本、图像及其他

2023年至2024年,多模态大型语言模型(MLLMs)如GPT-4V和GPT-4o将文本、图像、音频和视频整合到统一系统中,实现了更丰富的交互和复杂问题解决。例如,GPT-4V在医疗保健和教育领域的应用展示了其跨模态能力。

开源与开放权重模型:AI民主化

2023年至2024年,开源和开放权重模型如Meta AI的LLaMA系列和Mistral AI的Mistral 7B加速了AI技术的普及。这些模型不仅降低了开发成本,还促进了社区驱动的创新。

推理模型:从模式识别到结构化思维

2024年,OpenAI的o1系列推理模型通过长链思维(Long CoT)和推理时计算控制,显著提升了复杂任务中的推理能力。例如,o1-preview在数学和编程任务中超越了GPT-4o,展示了结构化思维的重要性。

DeepSeek-R1:成本效率的典范

2025年,DeepSeek推出的R1系列模型通过专家混合架构(MoE)和强化学习技术,实现了高性能推理与极低成本的结合。例如,DeepSeek-R1在数学、编码和写作任务中表现出色,其成本仅为OpenAI类似模型的1/30。

结论

从Transformer到DeepSeek-R1,LLMs的演进不仅推动了AI技术的进步,还深刻改变了社会与行业的运作方式。未来,随着多模态、开源和成本效率的进一步发展,LLMs将继续在更多领域发挥其潜力,为人类创造更多价值。