DeepSeek R1模型:测试时间缩放的典范

在AI模型的训练与推理过程中,测试时间缩放(Test Time Scaling)技术正逐渐成为降低计算成本、提升效率的关键。DeepSeek R1模型凭借其创新的低秩KV压缩和动态负载均衡技术,成为这一领域的典范。R1模型通过优化推理阶段的资源分配,显著减少了显存占用和计算开销,使得大规模AI模型的部署更加经济高效。

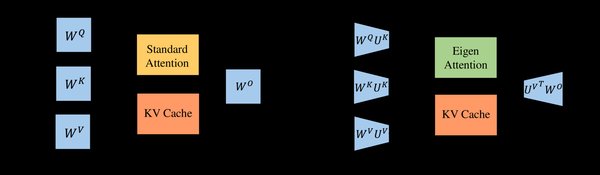

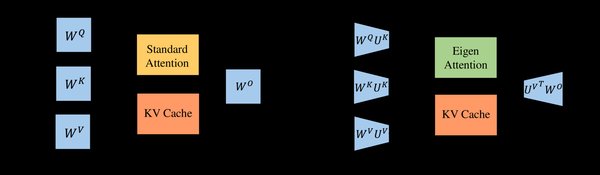

低秩KV压缩:突破显存瓶颈

DeepSeek R1模型采用了多头潜注意力(MLA)技术,通过对键值(KV)矩阵进行低秩压缩,将传统的KV缓存机制重构为更高效的潜向量形式。这种技术不仅减少了显存占用,还提升了计算效率。例如,在8K上下文长度的客服对话场景中,单个H800 GPU的并发处理能力从120 QPS提升至692 QPS,响应延迟从230ms降低至89ms,单次推理成本更是从0.0023美元降至0.0007美元。

动态负载均衡:优化资源分配

R1模型还引入了动态负载均衡技术,通过监控和调整专家模块的激活次数,确保每个专家在训练和推理过程中都能得到合理利用。这种无辅助损耗的负载均衡策略,不仅提高了训练稳定性,还显著降低了计算资源的浪费。例如,在H800 GPU集群中,DeepEP通信库通过优化全对全通信模式,将通信效率提升了30%以上,使得分布式训练成本下降30%。

测试时间缩放的三阶段

测试时间缩放技术可以分为三个阶段:预训练、后训练和推理阶段。DeepSeek R1模型在这三个阶段都展现出了卓越的性能优化能力。

预训练阶段:高效数据供给

在预训练阶段,R1模型通过优化数据处理和过滤算法,减少了信息冗余,提升了训练效率。例如,在14.8万亿Token的预训练数据集上,R1模型通过文档打包技术,减少了短文本块训练的浪费,显著提升了训练速度。

后训练阶段:强化学习优化

后训练阶段是模型“学习解决问题”的关键环节,R1模型通过强化学习和微调技术,持续优化模型性能。这一阶段消耗的算力远超预训练,但R1模型通过低秩KV压缩和动态负载均衡技术,显著降低了计算成本。

推理阶段:高效资源利用

在推理阶段,R1模型通过测试时间缩放技术,显著提升了推理效率。例如,在BERT等高精度模型推理中,FP8量化技术实现了4.5倍加速且精度无损,使得中小机构也能以更低成本部署大规模模型。

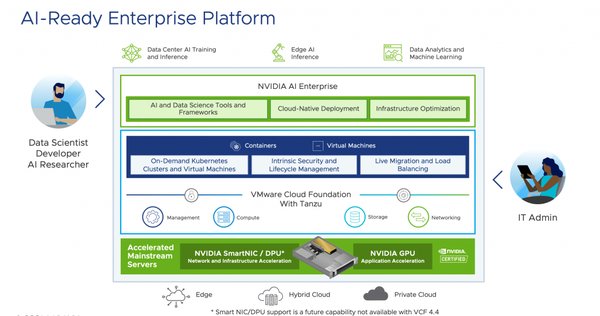

对AI基建产业链的影响

DeepSeek R1模型的创新技术对GPU、光模块等AI基建产业链产生了深远影响。

GPU市场:需求持续增长

R1模型的高效推理能力增加了对GPU的需求。例如,英伟达Blackwell架构GPU通过优化推理AI模型,将吞吐量提高了25倍,成本降低了20倍。尽管R1模型降低了计算成本,但其高效推理能力反而增加了对高性能GPU的需求。

光模块与通信网络:性能提升

R1模型的低秩KV压缩和动态负载均衡技术,减少了对高带宽通信网络的依赖。例如,DeepEP通信库通过优化NVLink与RDMA间的非对称带宽传输,提升了通信效率,降低了训练成本。

结论

DeepSeek R1模型通过测试时间缩放技术,显著降低了AI推理成本,提升了计算效率。其对GPU、光模块等AI基建产业链的深远影响,将进一步推动AI技术的普及和应用。随着测试时间缩放技术的不断发展,AI模型的部署将更加经济高效,为各行各业带来更多创新机遇。