引言

在人工智能领域,DeepSeek R1推理模型的推出标志着中国AI技术的又一重大突破。该模型不仅在推理能力上表现出色,还通过创新的训练方法和强化学习策略,展示了其在复杂问题解决中的潜力。

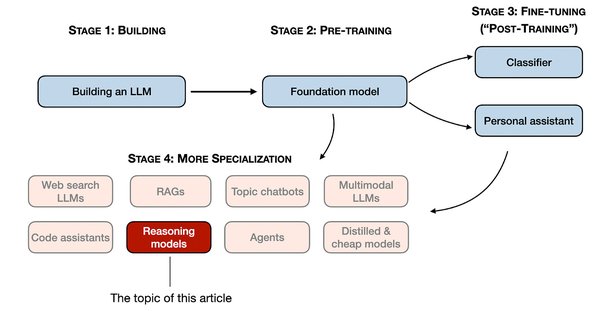

训练流程解析

阶段一:COT数据质量提升

- 基座模型:使用DeepSeek V3 Base作为初始基座。

- 训练步骤:

- SFT训练:用初始逻辑推理数据进行监督微调。

- RL强化训练:优化得到Model RL-1,提升推理轨迹的生成质量。

- 核心目的:生成更高质量的新COT数据,随后弃用Model RL-1,仅保留新数据。

阶段二:干净基座再训练

- 基座模型回退:重新使用原始DeepSeek V3 Base,避免低质量数据污染。

- 数据混合:使用新COT数据和Post-training数据,防止模型遗忘其他能力。

- 训练流程:再次回到base模型上,进行SFT和两阶段RL训练。

技术价值思考

- 无需SFT的RL训练:r1 zero证明了无需显式提供long cot数据,仅通过RL训练即可取得强大的reasoning能力。

- 自我进化:随着训练steps的增加,r1 zero倾向于产出更长的response,并出现反思行为。

- 小模型的推理能力提升:通过知识蒸馏和强化学习,小模型的推理能力也能显著提升。

实践应用

高考数学测试

在《2024年高考新课标一卷数学真题》测试中,DeepSeek-R1表现优异,准确率远超其他模型。

Deepscaler项目

UC伯克利的研究团队基于DeepSeek-R1-Distilled-Qwen-1.5B,通过简单的强化学习微调,得到了全新的DeepScaleR-1.5B-Preview,在AIME2024基准中,Pass@1准确率高达43.1%。

Logic-RL项目

中科大某大四科研小组复现了Logic-RL项目,证明了通过三阶段Rule Based RL,模型学会了多路径探索、回溯分析和阶段性总结等复杂推理行为。

结论

DeepSeek R1推理模型通过其创新的训练方法和强大的推理能力,不仅展示了中国AI技术的进步,也为全球AI领域的发展提供了新的思路和方向。未来,随着更多实践应用的展开,该模型有望在更多领域发挥其潜力,推动AI技术的进一步发展。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...