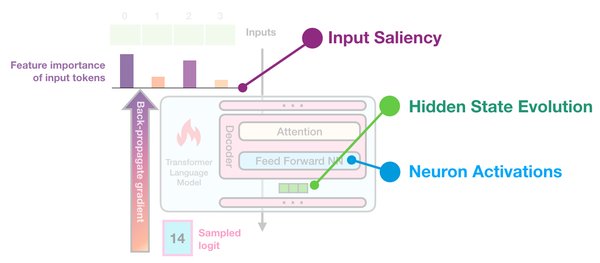

Transformer架构:大语言模型的基石

近年来,大语言模型(如GPT-4、Claude)的快速发展引起了广泛关注。这些模型的强大能力背后,离不开Transformer架构的支持。Transformer架构通过自注意力机制(Self-Attention Mechanism)实现了对长距离依赖关系的有效捕捉,从而显著提升了模型的语言理解和生成能力。

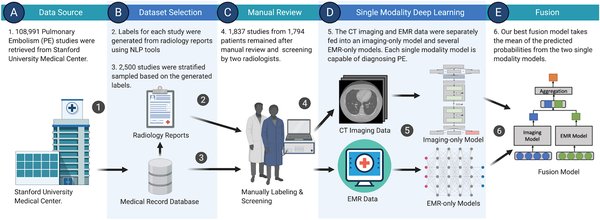

多模态融合与深度学习

随着技术的进步,多模态融合技术逐渐成为大语言模型发展的新趋势。通过将文本、图像、音频等多种模态的数据进行融合,模型能够更好地理解和处理复杂的现实世界任务。深度学习和海量数据的预训练则是实现这一目标的关键。通过大规模的数据训练,模型能够从海量信息中学习到丰富的知识,从而实现能力的跃升。

开源框架与商业化API

开源框架和商业化API的普及,极大地降低了大语言模型的使用门槛。例如,OpenAI的GPT系列模型和文心一言等商业化API,为开发者和企业提供了便捷的接入方式。这些工具不仅简化了模型的部署和使用,还推动了技术的广泛应用和落地。

提示词工程与模型微调

在实际应用中,提示词工程(Prompt Engineering)和模型微调(Fine-tuning)是两个重要的技术手段。提示词工程通过精心设计输入提示,引导模型生成更符合预期的输出。模型微调则通过在小规模数据集上进一步训练,使模型更好地适应特定任务。这些技术的应用,极大地提升了模型的实用性和灵活性。

AI伦理与合规

随着大语言模型的广泛应用,AI伦理和合规问题也日益受到关注。如何在确保技术创新的同时,避免潜在的伦理风险,成为了业界关注的焦点。开发者社区和AI营地在推动技术落地的过程中,也积极探讨和制定相关规范和标准,以确保技术的健康发展。

开发者社区的推动作用

开发者社区在推动大语言模型技术落地方面发挥了重要作用。通过开源项目、技术论坛和线下活动,开发者们能够分享经验、交流技术,共同推动技术的进步和应用。AI营地等平台则为开发者提供了学习和实践的机会,促进了技术的普及和推广。

Transformer架构为大语言模型的发展提供了坚实的基础,而多模态融合、深度学习、开源框架和商业化API等技术手段则进一步推动了模型的进步和应用。在提示词工程、模型微调、AI伦理和开发者社区的共同努力下,大语言模型正朝着更加智能化、实用化和规范化的方向快速发展。