英伟达H100:AI算力的巅峰之作

英伟达H100作为当前AI算力领域的旗舰产品,凭借其卓越的性能和广泛的应用场景,成为了全球AI开发者和企业的首选。H100基于Hopper架构,采用台积电4nm工艺,拥有高达800亿个晶体管,单芯片性能较上一代A100提升了3倍。其支持FP8、FP16、FP32等多种精度计算,特别适合深度学习、高性能计算和AI推理任务。

H100的核心优势

- 高性能计算:H100在AI训练和推理任务中表现出色,单芯片可提供高达2 PetaFLOPS的算力,支持大规模并行计算。

- 内存带宽:H100搭载了HBM3高带宽内存,内存带宽高达3 TB/s,显著提升了数据处理效率。

- 能效比:H100在保持高性能的同时,能效比显著提升,降低了数据中心的运营成本。

- 软件生态:英伟达CUDA平台和TensorRT推理引擎为H100提供了强大的软件支持,简化了AI模型的部署和优化。

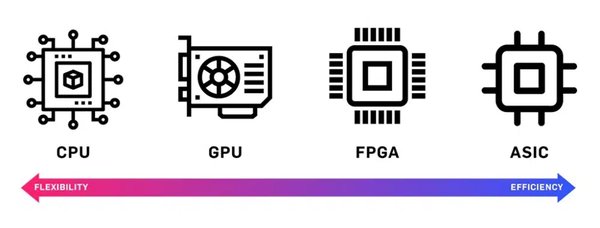

GPU与ASIC的竞争格局

尽管H100在AI算力领域占据主导地位,但定制化ASIC芯片的崛起正在改变市场格局。亚马逊、谷歌等科技巨头纷纷推出自研ASIC芯片,如亚马逊的Trainium和谷歌的TPU,这些芯片在特定任务中表现出更高的性能和能效比。

ASIC的优势

- 定制化设计:ASIC针对特定任务优化,性能更高效。

- 能效比:ASIC在同等算力下功耗更低,适合大规模部署。

- 成本优势:ASIC在大规模量产时,单位成本显著低于GPU。

然而,ASIC的高昂NRE(一次性工程费用)和有限的通用性仍然是其推广的主要障碍。相比之下,GPU凭借其通用性和成熟的生态,仍然是AI算力的主流选择。

推理计算的崛起

随着AI应用从训练转向推理,推理计算的需求正在快速增长。英伟达H100在推理任务中表现出色,支持FP8精度计算,显著提升了推理速度和能效比。根据巴克莱的报告,推理计算需求预计将占通用人工智能总计算需求的70%以上,甚至超过训练计算需求的4.5倍。

推理计算的关键技术

- 低精度计算:FP8等低精度计算技术显著提升了推理速度和能效比。

- 内存优化:HBM3等高带宽内存技术提升了数据处理效率。

- 软件优化:TensorRT等推理引擎优化了模型部署和推理效率。

未来趋势与挑战

未来,AI算力需求将持续增长,特别是在大模型训练、自动驾驶和边缘计算等领域。英伟达H100凭借其卓越的性能和广泛的生态支持,将继续引领AI算力市场。然而,ASIC的崛起和推理计算的快速发展也为市场带来了新的挑战和机遇。

未来趋势

- 算力需求增长:AI应用场景的扩展将推动算力需求持续增长。

- 技术创新:低精度计算、内存优化和软件生态的持续创新将提升算力效率。

- 市场竞争:GPU与ASIC的竞争将推动技术进步和成本降低。

英伟达H100作为AI算力的巅峰之作,将继续在AI发展中发挥关键作用。随着技术的不断进步和市场的快速发展,AI算力领域将迎来更多创新和突破。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...