DeepSeek近日宣布将DeepEP向公众开放,这一消息在AI技术圈和开发者社区引发了广泛关注。DeepEP作为一款专为MoE(Mixture-of-Experts)模型训练和推理优化的高性能通信库,不仅支持FP8低精度计算,还针对现代高性能计算中的关键通信场景进行了深度优化,尤其是NVLink和RDMA的非对称带宽转发场景。本文将深入探讨DeepEP的技术特点及其对AI行业的影响。

DeepEP的技术亮点

1. 支持FP8低精度计算

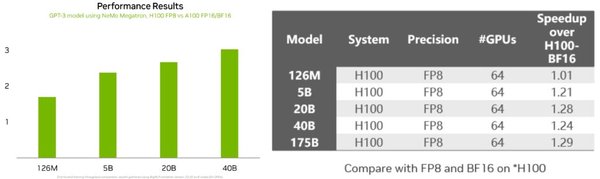

DeepEP支持FP8(8-bit浮点数)数据格式,这种低精度计算在保证模型性能的同时,显著降低了计算和通信的开销。FP8的使用不仅减少了数据传输量,还提高了计算效率,特别是在大规模模型训练中,这种优化尤为重要。

2. 针对NVLink和RDMA的深度优化

DeepEP针对NVLink和RDMA两种高性能通信场景进行了深度优化。NVLink主要用于GPU之间的高速通信,而RDMA(远程直接内存访问)则适用于分布式系统中的跨节点通信。DeepEP通过优化这两种场景的通信模式,显著提升了通信效率,减少了模型训练和推理中的通信瓶颈。

3. 高吞吐量性能

DeepEP提供了高吞吐量的通信操作,特别是在MoE模型的训练和推理预填充阶段。这种高吞吐量性能使得DeepEP能够在大规模模型训练中表现出色,显著提升了模型的训练速度和推理效率。

DeepEP对AI行业的影响

1. 推动国产AI芯片发展

DeepEP的开源为国产AI芯片厂商提供了宝贵的技术参考。通过DeepEP的优化技术,国产AI芯片厂商可以更好地理解AI模型的需求,进行针对性的优化。这不仅有助于提升国产AI芯片的性能,还能加速国产AI生态的发展。

2. 激活一体机市场

DeepEP的高性能通信优化也推动了一体机市场的快速发展。一体机作为结合算力、存储和网络的小型数据中心,能够满足金融、能源、政务等数据敏感型行业对安全和隐私的要求。DeepEP的优化技术使得一体机在本地化部署中表现出色,进一步推动了市场需求。

3. 提升AI模型训练效率

DeepEP的优化技术显著提升了AI模型的训练效率,特别是在大规模模型训练中。通过减少通信瓶颈和优化计算效率,DeepEP使得模型训练更加高效,降低了训练成本,为AI技术的普及和应用提供了有力支持。

总结

DeepEP的开源为AI行业带来了新的技术突破,特别是在高性能通信和低精度计算方面。通过支持FP8低精度计算和针对NVLink、RDMA场景的深度优化,DeepEP显著提升了MoE模型训练和推理的通信效率,推动了国产AI芯片和一体机市场的发展。随着DeepEP的广泛应用,AI行业将迎来更加高效和普及的发展阶段。