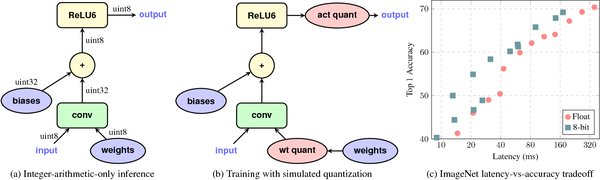

在深度学习的推理阶段,量化技术被广泛用于加速模型的计算速度并减少内存占用。然而,尽管INT4量化模型在理论上应该比FP8更快,实际情况却并非总是如此。本文将从硬件支持、内存访问模式和计算开销三个方面,深入解析INT4量化模型在推理时速度可能不如FP8的原因。

硬件支持

现代GPU如Nvidia RTX 4080对INT4的支持有限。虽然INT4在某些硬件上能够实现更低的计算精度,但其硬件支持并不如FP8广泛。例如,Nvidia的Blackwell架构引入了对FP4和INT4的支持,但实际应用中,INT4的计算效率并不一定优于FP8。这是因为INT4的计算单元可能需要进行额外的位操作,从而增加了计算开销。

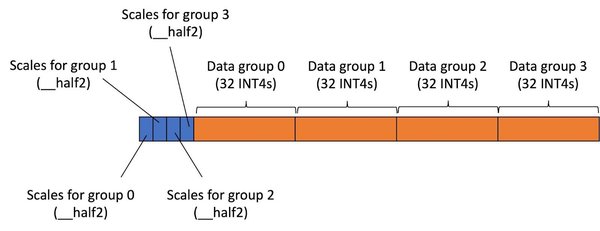

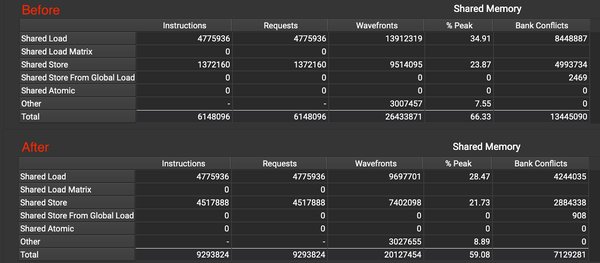

内存访问模式

INT4量化模型在内存访问效率上可能不如FP8。INT4由于非字节对齐,可能导致内存访问效率低下。具体来说,INT4的数据类型在内存中可能需要进行额外的对齐操作,这会增加内存访问的延迟。而FP8由于字节对齐,能够更高效地访问内存,从而减少推理时间。

计算开销

INT4量化模型在计算开销上可能比FP8更大。虽然INT4的计算精度更低,但在实际计算过程中,INT4可能需要进行额外的位操作,如移位和掩码操作,这会增加计算开销。此外,INT4的计算单元可能不如FP8的计算单元高效,从而进一步影响推理速度。

对比表格

| 特性 | INT4量化模型 | FP8量化模型 |

|---|---|---|

| 硬件支持 | 有限 | 广泛 |

| 内存访问效率 | 低 | 高 |

| 计算开销 | 高 | 低 |

结论

综上所述,INT4量化模型在推理时速度可能不如FP8量化模型,主要原因是硬件支持有限、内存访问效率低下和计算开销较大。尽管INT4在理论上应该更快,但在实际应用中,FP8可能通过更高效的硬件支持和内存访问模式,实现更快的推理速度。未来,随着硬件技术的进步,INT4的计算效率可能会有所提升,但在当前阶段,FP8仍然是更优的选择。

通过本文的分析,我们希望能够帮助读者更好地理解INT4和FP8量化模型在推理速度上的差异,并为模型优化提供有价值的参考。