引言

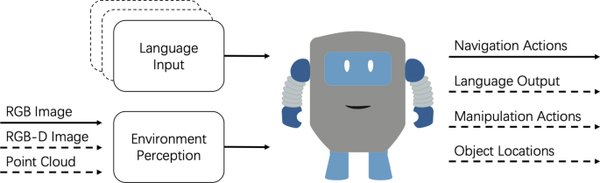

视觉语言导航(VLN)是具身智能领域的重要研究方向,旨在开发能够根据人类指令进行导航的智能体。然而,传统的VLN任务通常依赖于静态环境和理想化的专家监督,限制了其在真实世界中的应用。为了突破这一局限,NeurIPS 2024精选论文《人类感知视觉语言导航》提出了一种全新的任务框架——人类感知视觉语言导航(HA-VLN),通过引入动态人机交互和扩展Room-to-Room (R2R) 数据集,为VLN系统注入了更强的现实性和适应性。

Room-to-Room (R2R) 数据集的创新

R2R 数据集是VLN领域的重要基准,要求智能体在真实建筑中根据人类生成的导航指令进行导航。该数据集包含22,000条指令,每条指令平均长度为29个单词,并与Matterport3D模拟器中的轨迹相关联。然而,R2R数据集的主要局限在于其静态性和缺乏对人类活动的考虑。

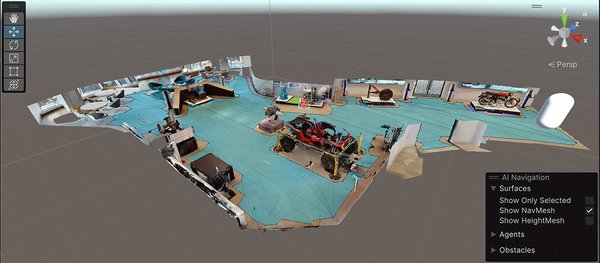

为了弥补这一不足,研究团队提出了人类感知Room-to-Room (HA-R2R) 数据集,扩展了R2R数据集的内容,加入了动态人类活动的描述。此外,团队还开发了人类感知3D (HA3D) 模拟器,将Matterport3D数据集与动态人类活动相结合,为HA-VLN任务提供了更真实的训练环境。

新型导航agent的开发与验证

为了应对HA-VLN任务的挑战,研究团队提出了两种新型导航agent:

-

专家监督跨模态agent (VLN-CM):利用跨模态融合技术,结合视觉和语言信息进行导航决策。

-

非专家监督决策Transformer agent (VLN-DT):通过多样化的训练策略,适应动态环境中的导航任务。

实验结果表明,这两种agent在动态人类环境中表现出色,显著提高了导航效率(NE)、目标碰撞率(TCR)、碰撞率(CR)和成功率(SR)等关键指标。然而,与理想化的“oracle”模型相比,现有agent仍存在显著的性能差距,凸显了HA-VLN任务的复杂性和挑战性。

HA-VLN任务的挑战与未来方向

HA-VLN任务的引入为VLN领域带来了新的研究方向,同时也暴露了现有模型的局限性:

-

动态环境的适应性:智能体需要在人类活动的动态环境中进行实时决策,这对模型的鲁棒性和灵活性提出了更高要求。

-

跨模态融合的优化:如何更有效地融合视觉和语言信息,仍然是提升导航性能的关键。

-

时间推理能力的增强:现有模型在时间推理能力方面表现不足,难以应对复杂的顺序决策任务。

未来研究需要进一步探索这些挑战,开发更强大的训练方法和模型架构,以提升HA-VLN系统的真实世界适应性和实用性。

结语

《人类感知视觉语言导航》研究通过引入动态人机交互和扩展R2R数据集,为VLN领域注入了新的活力。HA3D模拟器和HA-R2R数据集的开发,以及VLN-CM和VLN-DT agent的成功验证,为具身智能和Sim2Real(从模拟到现实)迁移研究提供了重要的技术支持和理论指导。未来,随着研究的深入,HA-VLN系统有望在服务机器人、智能家居等领域发挥更大的作用,推动人工智能技术向更高层次发展。