大语言模型的预训练框架

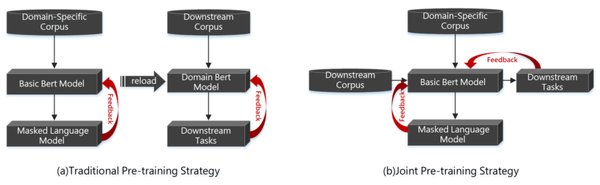

大语言模型(LLM)的预训练是AI领域的重要技术之一。目前,多个开源框架在这一领域表现突出。例如,基于PyTorch的Deepspeed和Megatron,它们通过优化模型训练过程中的内存使用和计算效率,显著提升了训练速度和模型性能。此外,Megatron-LM和Triton等工具也在模型并行化和计算优化方面提供了强大的支持。Huggingface Transformer作为预训练框架的代表,因其易用性和灵活性,成为了许多研究者和开发者的首选。

推理加速技术的进展

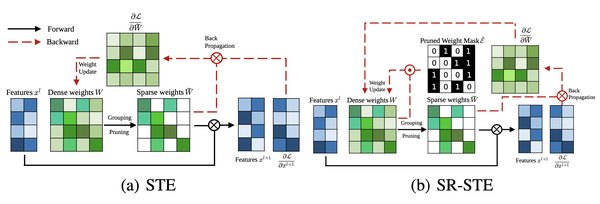

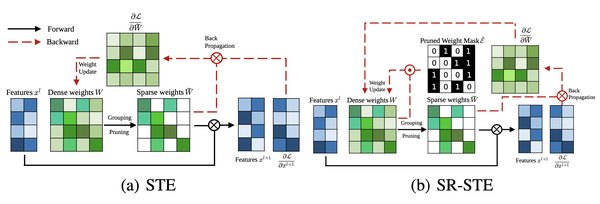

随着模型规模的不断增大,推理阶段的效率和资源消耗成为了新的挑战。现有的技术主要集中在数据级别、模型级别和系统级别的优化上。数据级别的优化包括输入压缩和输出组织,旨在减少计算和内存成本。模型级别的优化则涉及模型结构的改进和压缩技术,如量化和稀疏化。系统级别的优化则通过高效的推理引擎和服务系统,提升整体性能。例如,FlashAttention和FlashDecoding等技术通过优化注意力计算和线性操作,显著提高了推理速度。

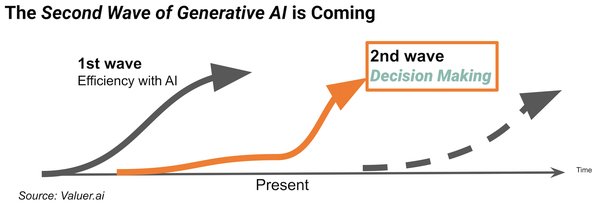

决策式AI与生成式AI的互补关系

决策式AI和生成式AI(AIGC)在垂直领域的应用各有侧重。决策式AI专注于通过数据分析和模型推理,做出最优决策,广泛应用于金融、医疗等领域。生成式AI则擅长于内容创作,如文本生成、图像生成等。两者在实际应用中往往需要结合使用,以发挥各自的优势。例如,在智能客服系统中,生成式AI可以生成自然的对话内容,而决策式AI则根据用户需求提供精准的解决方案。

实践中的挑战与未来方向

尽管大语言模型和决策式AI在多个领域取得了显著进展,但仍面临诸多挑战。例如,模型推理的效率问题、数据隐私和安全问题,以及模型的可解释性问题。未来的研究方向可能包括更高效的模型压缩技术、更安全的推理框架,以及跨领域的模型应用研究。通过不断的创新和实践,我们有望在AI领域实现更大的突破,推动技术的广泛应用和普及。