Transformer技术的核心:词向量与位置编码

Transformer模型自提出以来,已成为自然语言处理领域的重要基石。其核心在于如何有效地表示和处理文本数据,其中词向量和位置编码是两个关键组成部分。

词向量查找:嵌入表示的基础

在Transformer模型中,词向量(Word Embeddings)是文本表示的基础。通过embedding_lookup函数,可以将输入的词ID转换为连续的向量表示。这一过程不仅考虑了词汇的大小(vocab_size),还定义了嵌入的维度(embedding_size),并通过初始化范围(initializer_range)来控制嵌入的初始值。此外,use_one_hot_embeddings参数允许选择使用一热编码或直接查找嵌入表,以适应不同的应用场景。

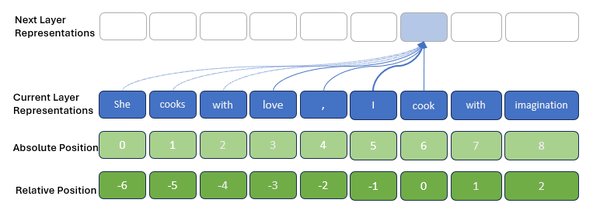

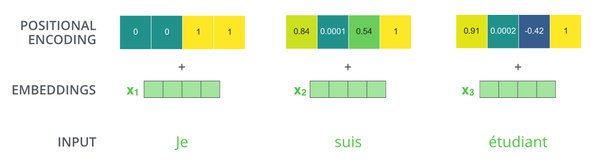

复值词向量函数:位置编码的创新

除了词向量,位置编码(Positional Encoding)在Transformer中也扮演着重要角色。传统的Transformer模型使用正弦和余弦函数来编码位置信息,但最新的研究提出了一种复值词向量函数,通过将复值函数的振幅和相位与词义和位置相联系,巧妙地生成绝对位置编码。这种方法不仅建模了绝对位置,还捕捉了词之间的相对位置关系,使得模型在处理长文本时更加高效。

大模型应用开发:从理论到实战

随着Transformer技术的不断发展,大模型应用开发已成为业界关注的焦点。以下是大模型应用开发中的几个关键点:

-

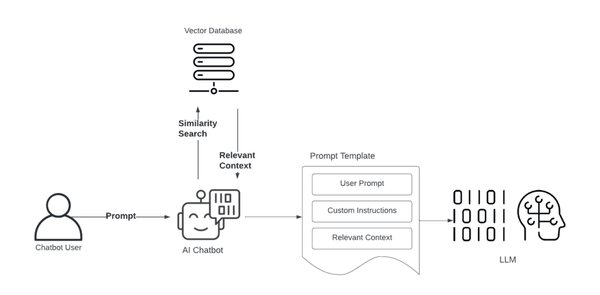

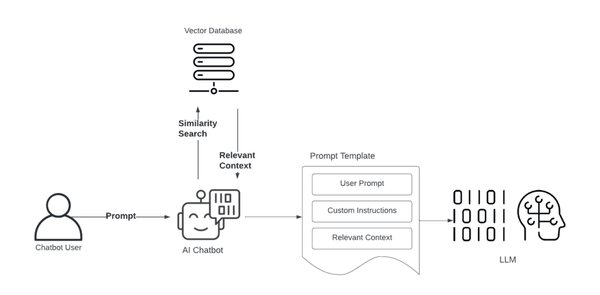

RAG技术的实战应用:RAG(Retrieval-Augmented Generation)技术结合了检索和生成,能够在大模型中实现更精准的信息检索和内容生成。

-

大模型的发展与演变:从最初的Transformer到如今的GPT、BERT等模型,大模型在自然语言处理、计算机视觉等多个领域取得了显著进展。

-

从0到1构建大模型:对于开发者而言,理解大模型的构建过程至关重要。从数据准备、模型设计到训练优化,每一步都需要深入的技术知识和实践经验。

结语

Transformer技术及其在大模型应用开发中的重要性不言而喻。通过深入理解词向量和位置编码等核心概念,开发者可以更好地掌握大模型技术,并将其应用于实际工作中,推动人工智能技术的进一步发展。