ROCm技术概述

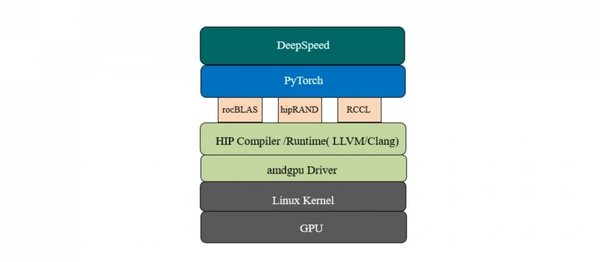

ROCm(Radeon Open Compute)是AMD推出的开源异构计算平台,旨在为高性能计算(HPC)和人工智能(AI)提供强大的加速支持。与NVIDIA的CUDA类似,ROCm通过开放的生态系统,允许开发者在AMD GPU上运行复杂的计算任务。

硬件升级与ROCm加速的挑战

在硬件升级过程中,用户可能会遇到ROCm加速失效的问题。例如,从Adrenaline 25.1.1升级到25.3.1后,AMD Radeon RX 7900 XTX的ROCm加速功能被破坏,导致PyTorch应用程序无法正常运行。这一问题不仅影响了AI模型的训练速度,还增加了调试和修复的复杂性。

关键问题点:

- ROCm版本兼容性:不同版本的ROCm可能对硬件支持存在差异,导致升级后加速失效。

- 软件框架依赖:PyTorch等机器学习框架对ROCm的依赖性强,任何底层驱动的变化都可能影响其性能。

- 调试难度:由于ROCm生态系统的复杂性,用户需要投入大量时间和精力进行调试和修复。

ROCm与CUDA的对比

ROCm和CUDA都是异构计算框架,但它们在生态系统、硬件支持和开发者社区方面存在显著差异。

| 特性 | ROCm | CUDA |

|---|---|---|

| 开源 | 是 | 否 |

| 硬件支持 | AMD GPU | NVIDIA GPU |

| 开发者社区 | 较小但逐渐增长 | 庞大且成熟 |

| 生态系统 | 开放但仍在完善 | 封闭但高度优化 |

机器学习中的ROCm应用

ROCm在机器学习中的应用日益广泛,特别是在PyTorch和TensorFlow等框架中。然而,其性能和稳定性仍面临挑战。例如,用户在升级Adrenaline驱动后,发现ROCm加速的AI模型训练时间从10秒增加到662秒,极大地影响了工作效率。

优化建议:

- 版本管理:在升级硬件驱动和ROCm版本时,需谨慎测试,确保兼容性。

- 社区支持:积极参与ROCm开发者社区,获取最新的技术支持和解决方案。

- 多框架支持:探索不同机器学习框架对ROCm的支持,选择最适合的应用场景。

未来展望

随着AI和高性能计算需求的增长,ROCm技术有望在更多领域得到应用。然而,其生态系统仍需进一步完善,以提供更稳定和高效的加速支持。开发者需持续关注ROCm的技术发展,探索其在异构计算中的潜力。

通过深入分析ROCm技术的现状与挑战,本文为开发者和技术爱好者提供了宝贵的参考,助力其在AI和高性能计算领域取得更大的突破。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...