引言

随着人工智能技术的飞速发展,混合专家模型(Mixture of Experts, MoE)因其高效的计算能力和灵活的架构设计,逐渐成为大规模语言模型的主流选择。近日,DeepSeek宣布将DeepEP向公众开放,这一举措无疑为MoE模型的训练和推理带来了革命性的突破。DeepEP作为MoE模型训练和推理的Expert Parallelism通信基础,支持包括FP8在内的低精度计算,并针对从NVLink到RDMA的非对称带宽转发场景进行了深度优化,提供了高吞吐量性能。

MoE模型的核心架构

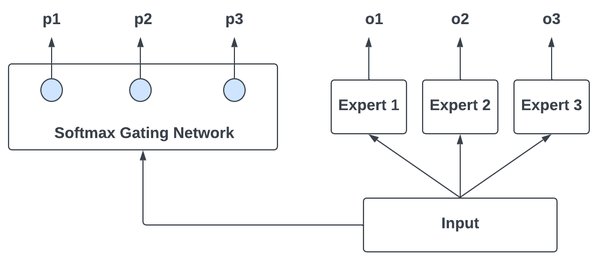

专家网络与门控网络

MoE模型的核心在于其专家网络和门控网络的设计。专家网络由多个子模型(专家)组成,每个专家负责处理特定类型的输入或任务。门控网络则根据输入特征动态选择最合适的专家进行处理,确保每次推理或训练时仅启动少量专家,从而显著降低计算开销。

稀疏激活与输出聚合

MoE模型通过稀疏激活机制,每次仅启动少量专家,减少计算资源的消耗。输出聚合模块则负责将多个专家的输出结果进行加权融合,生成最终答案。这种设计不仅提高了模型的计算效率,还增强了其任务适应性和泛化能力。

DeepEP的技术优势

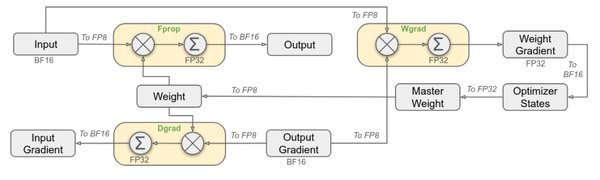

支持FP8低精度计算

DeepEP支持FP8低精度计算,相较于传统的FP16或BF16训练方式,FP8策略在保持模型精度的同时,大幅减少了训练成本。这一技术优势为MoE模型的高效训练和推理提供了强有力的支持。

非对称带宽转发优化

DeepEP针对从NVLink到RDMA的非对称带宽转发场景进行了深度优化,提供了高吞吐量性能。这种优化不仅提高了数据传输效率,还降低了通信开销,为现代高性能计算提供了更高效的解决方案。

DeepEP的应用场景

自然语言处理

在自然语言处理领域,DeepEP可以用于文本分类、情感分析、机器翻译等任务。其高效的推理过程和轻量级设计使得模型能够在资源受限的设备上进行部署,为移动应用、智能客服等场景提供了高效的解决方案。

计算机视觉

在计算机视觉领域,DeepEP可以用于图像分类、目标检测、图像生成等任务。其高效的推理过程使得模型能够在实时应用中表现出色,如智能监控、自动驾驶等场景。

物联网与边缘计算

在物联网与边缘计算领域,DeepEP的轻量级设计使得其能够在资源受限的设备上进行部署。例如,在智能家居、工业物联网等场景中,DeepEP可以实现高效的推理,从而提升系统的智能化水平。

未来展望

技术创新与开源生态

DeepSeek通过开放DeepEP,不仅推动了MoE模型的技术创新,还促进了开源生态的建设。未来,随着更多开发者和企业的参与,MoE模型将在更多领域发挥重要作用,推动人工智能技术的进一步发展。

行业应用拓展

DeepEP的成功应用为国产AI大模型的发展提供了重要的技术和商业参考。未来,国产AI大模型应加大技术创新投入,推动开源生态建设,并积极拓展行业应用,进一步提升全球竞争力。

结语

DeepSeek宣布开放DeepEP,这一举措为MoE模型的训练和推理带来了革命性的突破。DeepEP支持FP8低精度计算,并针对非对称带宽转发场景进行了深度优化,提供了高吞吐量性能。未来,随着更多开发者和企业的参与,MoE模型将在更多领域发挥重要作用,推动人工智能技术的进一步发展。