引言

在AI领域,DeepSeek R1-Zero模型的推出标志着推理能力的一次重大飞跃。该模型通过强化学习和大规模预训练,展示了卓越的推理能力,无需依赖有监督微调。本文将深入探讨R1-Zero的创新架构、训练方法及其在AI领域的影响。

R1-Zero的创新架构

混合专家架构(MoE)

DeepSeek R1-Zero采用了混合专家架构(MoE),将模型分割为多个子模型,每个子模型专注于特定领域的任务。这种架构不仅提高了模型的效率,还显著降低了计算成本。

“`markdown

| 架构特性 | 描述 |

|---|---|

| 子模型数量 | 多个,专注于不同领域 |

| 计算成本 | 显著降低 |

| 效率 | 提高 |

“`

多头潜注意力机制(MLA)

R1-Zero引入了多头潜注意力机制(MLA),通过低秩近似技术压缩键值矩阵,显著减少了KV缓存的大小,从而提高了推理效率。

训练方法

强化学习

R1-Zero的训练完全依赖于强化学习,无需有监督微调。这种方法不仅降低了训练成本,还使模型能够自主进化,展现出更长的思维链和自我反思能力。

“`markdown

| 训练方法 | 优势 |

|---|---|

| 强化学习 | 自主进化,降低训练成本 |

| 无监督微调 | 减少人工干预,提高效率 |

“`

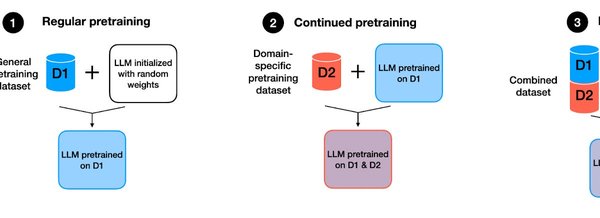

大规模预训练

R1-Zero在14.8万亿个高质量token上进行了预训练,确保了模型在推理任务中的卓越表现。

应用与影响

推理能力

R1-Zero在数学和逻辑推理任务中表现尤为突出,能够处理复杂的推理问题,并生成详细的思维链。

“`markdown

| 任务类型 | 表现 |

|---|---|

| 数学推理 | 卓越 |

| 逻辑推理 | 突出 |

“`

开源策略

DeepSeek的开源策略不仅推动了AI技术的普及,还促进了全球开发者的创新。R1-Zero的开源代码和模型参数为研究者提供了宝贵的研究资源。

结论

DeepSeek R1-Zero模型通过其创新的架构和高效的训练方法,为AI领域带来了革命性突破。其卓越的推理能力和开源策略不仅推动了技术的发展,还为未来的AI研究提供了新的方向。

通过深入探讨R1-Zero的创新点和应用价值,我们可以看到,这一模型不仅是技术上的突破,更是AI领域的一次重大飞跃。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...