随着人工智能技术的迅猛发展,大模型在各行各业中的应用日益广泛,但其安全性问题也逐渐浮出水面。本文将从数据准备、预训练、微调和推理四个阶段,深入探讨大模型可能面临的安全风险,并提出相应的解决方案。

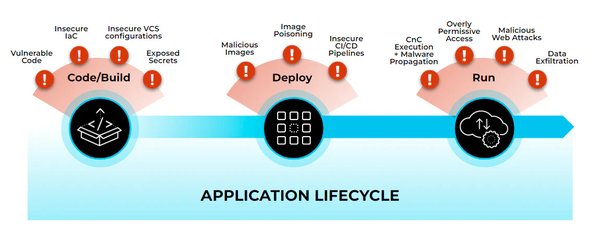

数据准备阶段:数据投毒与供应链安全

在数据准备阶段,数据和模型的投毒攻击尤为突出。攻击者可以通过注入恶意样本,使得模型在训练过程中出现偏差或后门。例如,2023年某互联网公司的实习生利用HuggingFace平台的漏洞进行了投毒攻击,严重损害了模型的训练成果。这种供应链安全问题提醒我们,确保数据来源的可靠性至关重要。

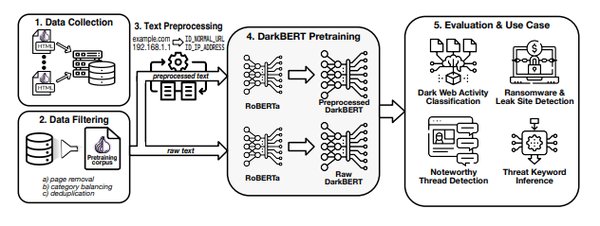

预训练阶段:敏感信息泄露

在预训练阶段,模型有可能无意中学习并记住敏感信息,导致敏感数据的泄露。DeepMind团队的研究揭示了ChatGPT的一个安全漏洞,攻击者可以提取到大量的训练数据,包括个人身份信息等。这不仅侵犯了个人隐私权,还对社会安全造成了隐忧。

微调阶段:后门植入与对抗攻击

微调阶段的安全风险同样不可小觑。在这一阶段,很多模型结合了检索增强生成(RAG)技术,但如果向量与嵌入的过程中存在漏洞,可能导致模型输出敏感信息和错误内容。研究表明,攻击者可以利用后门植入和对抗攻击等手段来操控模型的输出结果,这种攻击方式相对容易实施,增加了模型被利用的风险。

推理阶段:提示词注入攻击

推理阶段是大语言模型实际应用的关键时刻,然而提示注入攻击也成了主要威胁。攻击者通过输入巧妙设计的提示,可覆盖模型预设的指令,从而使其输出不当内容,甚至是敏感信息。例如,北美一款蘑菇识别AI因识别错误导致数十人中毒事件,正是恶性后果的生动实例。

解决方案:加强安全架构与漏洞检测

面对这些安全挑战,各大企业和研究机构必须加强对安全漏洞的测试与防护。以下是几项关键措施:

-

安全架构设计:引入零信任理念,对内部网络、接口和数据传输实施严格验证。采用全链路安全、分层防护及零信任等先进理念,确保整个模型生命周期的安全性。

-

漏洞检测与修复:提升自动化检测能力和响应速度,并构建闭环管理。例如,微软通过MSRC为AI相关漏洞提供最高3万美元的奖励,并明确漏洞类型和危害等级。

-

数据合规性审查:重视数据来源合法性、敏感信息脱敏、针对性测试设计及持续监控。采用数据分类分级管理,对核心敏感数据进行端到端加密,并建立数据血缘追踪体系,确保数据在全生命周期内可审计。

结论:共建人工智能安全未来

大模型的安全问题不仅是技术挑战,更是道德与法律的考验。生产企业在享受技术红利的同时,更要正视可能带来的社会风险。通过多方合作、透明的信息分享,才能真正为大模型的安全应用建立完善的防护体系,确保这一复杂系统能够在各领域内健康发展。只有这样,才能让大模型技术更好地服务于社会,为人类的未来创造更大价值。

通过以上措施,我们有望在2025年及以后,共同构建一个更加安全、可靠的人工智能生态系统。