长思维链(Long CoT)技术的崛起

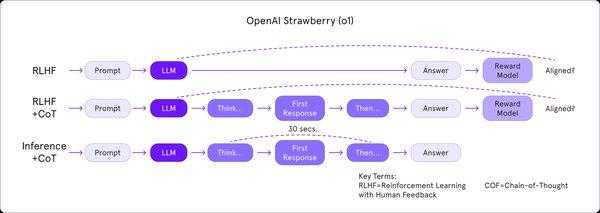

在人工智能领域,长思维链(Long CoT)技术正逐渐成为提升模型推理能力的关键。通过扩展上下文窗口长度和优化策略,长思维链技术能够在复杂任务中实现更高效的推理与决策。近年来,Kimi-1.5作为这一技术的代表,凭借其独特的技术创新,在多模态推理和强化学习中取得了显著突破。

Kimi-1.5的技术创新

Kimi-1.5的成功并非偶然,其背后是多项核心技术的支持。以下是其技术创新的几个关键点:

- 长上下文扩展

Kimi-1.5将强化学习的上下文窗口扩展至128k,并观察到随着上下文长度的增加,模型性能持续提升。这一技术在处理长篇文档分析、长序列数据处理等任务时具有显著优势。

- long2short思维链方法

该方法通过将长CoT模型的推理先验转移到短CoT模型中,提高了Token使用效率。具体步骤包括模型合并、最短筛选采样和DPO(Direct Preference Optimization)等,显著提升了短链思维推理的效率。

- 强化学习基础设施:部分回滚技术

Kimi-1.5引入了部分回滚(Partial Rollout)技术,通过限制输出Token预算和异步处理回滚任务,降低了计算开销,同时保持了快速迭代能力。

- 多模态能力全面提升

在文本、推理和视觉基准测试中,Kimi-1.5展现了与OpenAI o1满血版相当甚至更优的性能,特别是在长距离推理和多模态数据处理方面表现突出。

实际应用中的表现

Kimi-1.5在实际应用中的表现同样令人瞩目。例如:

-

文本处理任务:在分析长篇文档时,Kimi-1.5能够高效提取核心信息,生成结构化表格。

-

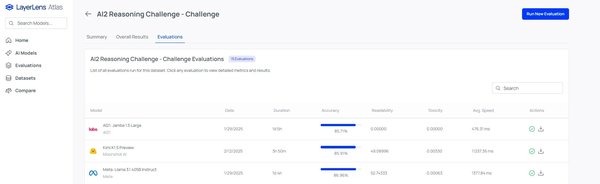

数学与代码推理:在AIME 2024、MATH 500和Codeforces等数据集中,Kimi-1.5的表现与DeepSeek-R1相当,展现了其强大的推理能力。

-

组合使用提升效率:Kimi-1.5与其他AI工具的组合使用,如通义千问和智谱清言,能够显著提高行业报告撰写和短视频制作的效率。

未来展望

Kimi-1.5的成功标志着长思维链技术在多模态推理领域迈出了重要一步。随着技术的不断优化,长思维链技术有望在更多复杂任务中发挥重要作用,推动人工智能技术的进一步发展。

Kimi-1.5的创新不仅为行业树立了新的标杆,也为未来的AI竞争格局注入了新的活力。我们期待这一技术能够为人类社会带来更多惊喜与价值。