硬件感知优化的技术突破

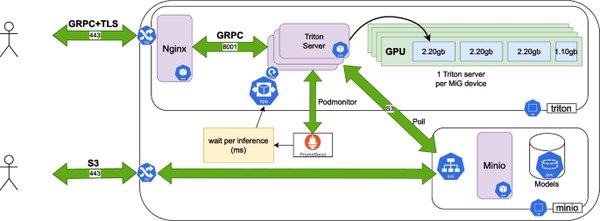

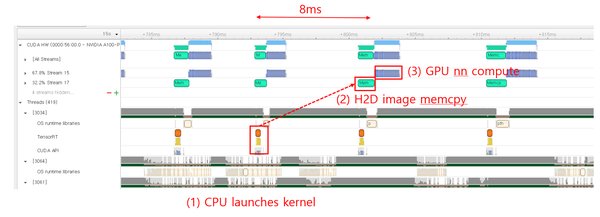

NVIDIA Triton推理服务器的最新发布标志着硬件感知优化技术的一次重大突破。通过在A100显卡上实现70B参数模型的推理速度突破,Triton服务器达到了每秒60个token的处理能力,较传统方案提升了4.5倍。这一成就的核心在于其创新的自适应计算图分割技术,该技术将复杂的模型分解为可并行化的微算子,并通过即时编译生成最优的GPU指令序列,使计算密度提升至理论峰值的93%。

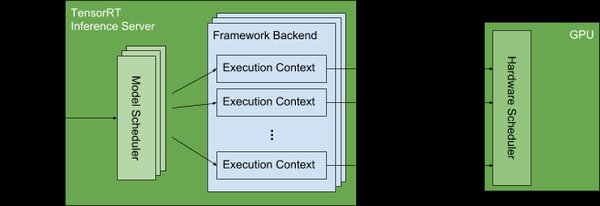

三重优化架构

Triton服务器的技术架构围绕三重优化展开:

-

混合精度调度器:通过动态调整计算精度,在保证模型准确性的同时最大化计算效率。

-

稀疏注意力核:针对大模型中的注意力机制进行优化,减少冗余计算,提升处理速度。

-

显存虚拟化技术:通过高效的显存管理,支持更大规模的模型推理,降低硬件资源需求。

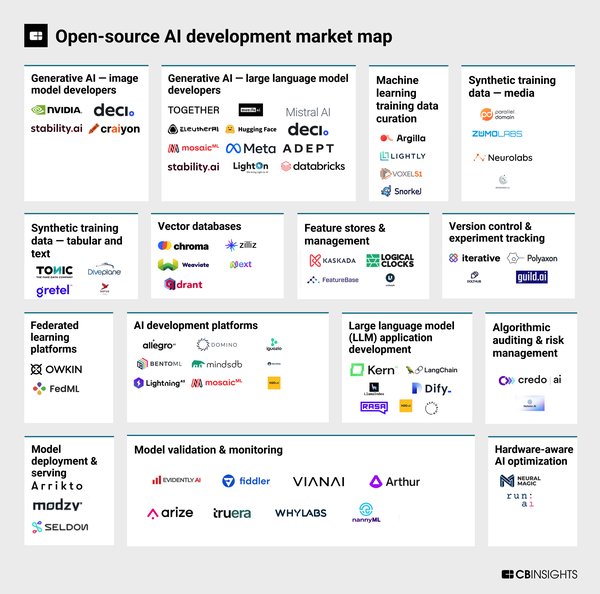

开源生态与行业应用

Triton服务器的开源生态已集成Hugging Face模型库,开发者可以通过简单的配置文件完成主流大模型的部署优化。随着对混合专家(MoE)架构的专项支持,Triton服务器正成为企业级AI落地的核心基建。其在实时交互、内容生成等场景中的应用,为行业提供了工业化级的解决方案。

未来展望

随着AI推理需求的快速增长,硬件感知优化技术的重要性愈发凸显。NVIDIA Triton服务器的成功不仅展示了其在技术上的领先地位,也为未来AI基础设施的建设指明了方向。随着更多企业采用这一技术,AI推理的效率与成本效益将进一步提升,推动AI技术在更广泛领域的应用。

NVIDIA Triton推理服务器的硬件感知优化技术,无疑是当前AI领域的一大亮点,其创新架构与开源生态的结合,为行业带来了前所未有的发展机遇。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...