引言

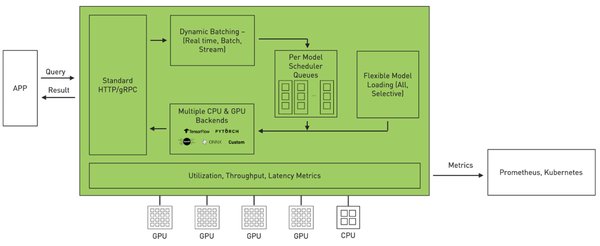

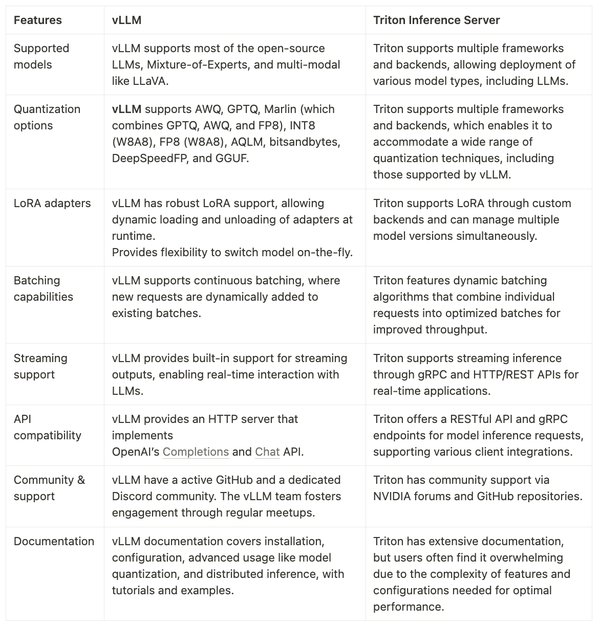

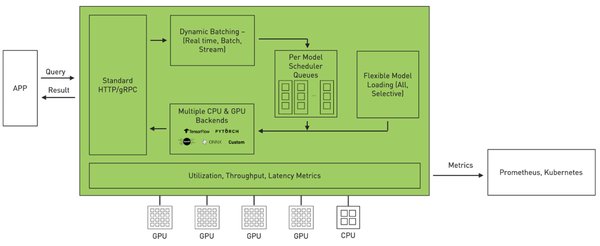

在人工智能领域,大语言模型(LLM)的参数规模持续增长,这对推理和训练提出了更高的要求。NVIDIA最新发布的Triton推理服务器通过动态批处理与硬件感知优化,在A100显卡上实现了70B参数模型的推理速度突破,达到每秒60个token,较传统方案提升4.5倍。本文将深入探讨Triton服务器的核心创新及其在实际应用中的表现。

动态批处理与硬件感知优化

Triton推理服务器的核心创新在于其自适应计算图分割技术。该技术将模型分解为可并行化的微算子,通过即时编译生成最优GPU指令序列,使计算密度提升至理论峰值的93%。具体来说,Triton服务器通过以下三重优化实现了这一突破:

-

混合精度调度器:根据模型的计算需求动态调整精度,从而在保证精度的同时最大化计算效率。

-

稀疏注意力核:优化注意力机制的计算,减少不必要的计算量,提升整体推理速度。

-

显存虚拟化技术:通过虚拟化技术优化显存使用,减少数据传输延迟,提升整体性能。

自适应计算图分割技术

自适应计算图分割技术是Triton服务器的另一大亮点。该技术将复杂的模型分解为多个可并行化的微算子,通过即时编译生成最优GPU指令序列。这种方法不仅提高了计算密度,还显著减少了推理时间。具体实现包括:

-

微算子分解:将复杂的计算任务分解为多个简单的微算子,便于并行处理。

-

即时编译:根据硬件特性生成最优的GPU指令序列,最大化硬件利用率。

开源生态与集成

Triton推理服务器的开源生态已集成Hugging Face模型库,开发者可通过配置文件完成主流大模型的部署优化。这一集成使得开发者能够更便捷地使用Triton服务器进行模型推理,从而加速AI应用的开发和部署。

MoE架构的专项支持

随着对MoE(Mixture of Experts)架构的专项支持,Triton服务器正成为企业级AI落地的核心基建。MoE架构通过将模型分解为多个专家模块,每个模块负责处理特定类型的任务,从而提升模型的推理效率。Triton服务器通过优化MoE架构的计算和通信,进一步提升了模型的推理速度和效率。

实际应用与性能评估

在实际应用中,Triton服务器在A100显卡上实现了70B参数模型的推理速度突破,达到每秒60个token,较传统方案提升4.5倍。这一性能提升不仅证明了Triton服务器的技术优势,也为实时交互、内容生成等场景提供了工业化级解决方案。

结论

NVIDIA Triton推理服务器通过动态批处理与硬件感知优化,在A100显卡上实现了70B参数模型的推理速度突破。其核心创新包括自适应计算图分割技术、混合精度调度器、稀疏注意力核和显存虚拟化技术。随着对MoE架构的专项支持,Triton服务器正成为企业级AI落地的核心基建,为实时交互、内容生成等场景提供工业化级解决方案。